共计 2562 个字符,预计需要花费 7 分钟才能阅读完成。

根据《华尔街日报》的最新消息,OpenAI 正在研发的下一代大型语言模型 GPT-5 的进展未能如预期顺利推进,目前所取得的成果并未能与其高昂的开发成本相匹配。

这一消息与之前《The Information》的报道相呼应,该报道曾暗示 OpenAI 正在寻找新的方向,因为 GPT-5 可能无法如其前身那样实现显著的性能提升。《华尔街日报》进一步揭示了代号为“猎户座”(Orion)的大型语言模型在长达 18 个月的研发过程中所面临的挑战。

报道指出,OpenAI 已完成至少两轮大规模训练,旨在通过庞大的数据集提高模型性能。然而,首次训练的进展超出预期,预示着后续更大规模的训练将耗费巨额时间和资金。尽管传言称 GPT-5 的性能优于前代产品,但其进步程度仍未能合理化维持该模型运作所需的巨额费用。

此外,OpenAI 还不仅依赖于公开数据和许可协议,还雇佣人员通过编写代码和解决数学问题来生成全新数据。同时,该公司也在利用其另一款模型 o1 生成的合成数据。

截至 IT 之家发稿时,OpenAI 尚未对此消息作出回应,而该公司早前曾表示,今年不会推出代号为“猎户座”的模型。

消息称 OpenAI 新模型 GPT-5 研发遇阻,成本高昂、效果未达预期

我查看了原文,WSJ 的这篇报道虽然提供了一些增量信息,但并不算多(MSN 可以绕过付费墙查看全文,推荐阅读)。主要表达的核心是 尽管 GPT-5 投入了大量资金进行训练,但研发进度滞后,原因在于数据资源的枯竭等问题。

归根结底,GPT 的训练似乎遭遇了数据瓶颈,类似的报道已经出现一个多月。我个人认为,这篇文章在强调 GPT 遇到的问题时,似乎忽视了 o1 和 o3 的成就。

再加上 OpenAI 前一天刚发布了新模型 o3,WSJ 在这个时候报道 GPT-5 训练遇阻的问题,难怪 Sam Altman 对 WSJ 的报道表现出了一些不满,或许是想说,既然你不赞扬我的 o3,为什么偏偏在这种喜庆的时刻提到我的短处呢。

通常来说,有关 OpenAI 的内部消息,最积极且最准确的爆料来源是 The Information,比如他们提前一天准确预告了 o3 的发布,并解释了跳过 o2 命名的原因是商标冲突,我一度怀疑这两个媒体在合作。

不过 The Information 也并非总是报喜不报忧,上个月他们就有一篇报道提到 OpenAI 正在调整战略,因为“GPT”人工智能的改进速度减缓,被评论为可能会动摇 AI 大模型的估值逻辑,指出了 GPT 下一代模型面临的数据瓶颈问题。

接下来我们回顾一下 The Information 的报道。根据其介绍,OpenAI 基础模型的研发进展放缓,内部人员透露,下一代旗舰模型 Orion 的质量提升未能达到预期,与 GPT-3 到 GPT-4 之间的进步相比有所不足。造成这一情况的主要原因是高质量文本数据的减少,使得 LLM 的预训练变得困难。为应对数据短缺,OpenAI 已组建团队并探索合成数据的应用,但这可能导致模型性能与旧模型相似。

如果这一问题属实,意味着以数据和算力投入为基础的规模法则,即只要有足够的数据和算力进行训练,LLMs 的效果将持续改善,可能会不再适用。如果规模法则不再成立,显然会影响当前 AI 初创公司的估值逻辑。

OpenAI 提出的另一条路径是转向 o 系列推理模型的研发,通过在推理时提供额外的算力来提高模型的响应质量,但这也涉及较高的成本。

然而,o 系列确实展现出强大的潜力,推动了行业向增加推理时间的方向发展,开辟了新的规模法则,谷歌的 Gemini 2 引入了思考能力,国内的 Qwen 推出了 QWQ,DeepSeek 发布了 r1,效果都相当不错。从这个角度来看,大模型的发展并没有停滞,我们离 AGI 的目标又近了一步。

对于程序员来说,当前正是一个宝贵的机遇。如果你打算入门大模型,不妨参与知乎知学堂的「大模型应用开发课」,由业内专家授课,帮助我们快速掌握大模型的技术原理、模型训练和应用开发,确保在 AGI 的道路上不掉队:

WSJ 的报道进一步补充了更多细节,例如:

- 自 GPT-4 发布后,OpenAI 就开始了 GPT-5(Orion)的训练,已经持续了 18 个月,作为主要投资方的 微软原本预计在 2024 年中期会看到新模型的问世,然而现在的进展明显已经延迟。

- 在此期间,至少进行了两轮大规模训练(如果一次训练耗时 6 个月,仅算力成本就超过 5 亿美元)。Orion 的表现充其量只比现有模型略好,远未达到预期。

- 训练过程中最大的问题是缺乏多样化和高质量的数据,如今的互联网公开数据几乎已经被消耗殆尽。

- OpenAI 选择从零开始创造数据,雇佣人员编写代码和数学问题的答案,并与理论物理等领域的专家合作解决复杂问题,同时利用人工智能生成合成数据。然而研究表明,人工合成数据可能导致模型不稳定或产生无意义的结果。

- OpenAI 内部面临人才流失,同时 不同项目组(如 Sora)之间在算力分配上也存在竞争。

因此,我认为,WSJ 这篇文章并未提供太多新的信息,因为数据墙的问题实际上是存在的,尽管 Sam Altman 上个月曾表示「没有墙」,但从 OpenAI 的行动来看,似乎已经转向了 o 系列模型的发展。

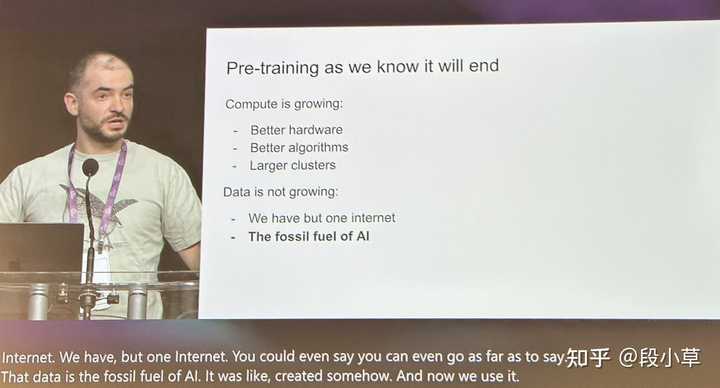

加之 Ilya 提出「我们所知的预训练将结束」,引发了广泛讨论。

归根结底,人们对 OpenAI 的期望值过高,竞争对手的实力也不容小觑,谷歌今年推出的多个模型和产品表现亮眼,Claude 也吸引了一部分忠实用户。

OpenAI 今年推出了 Sora 的文生视频、4o 的多模态能力,以及 o1/o3 的推理,这些在 GPT 的数据困境中帮助其勉强维持了领先地位。当然,也不能否认 OpenAI 可能会引领大家误入歧途,导致在错误方向上投入过多资源。

我认为 OpenAI 并未放弃 GPT 系列,只是暂时需要 o 系列来稳定投资者的信心,预训练基础模型与推理模型并非对立,而应是相辅相成、共同发展的。只有当 GPT-5 实现显著提升,基于 GPT-5 的 o5 才可能进一步突破,否则 o 系列将可能成为一个算力黑洞,陷入无尽的循环当中。