共计 3149 个字符,预计需要花费 8 分钟才能阅读完成。

阿里全新语音识别模型 Qwen3-ASR-Flash 的发布

阿里巴巴推出了其最新的语音识别大模型 Qwen3-ASR-Flash,这是 Qwen3 系列中的首个语音识别模型,其在中英文语音识别的错误率上低于 GPT-4o-transcribe 和 Gemini 2.5 Pro。不过,值得注意的是,该模型目前仅通过 API 提供,不会开源!

Qwen3-ASR-Flash 模型的主要特性

Qwen3-ASR-Flash 模型的基础源自尚未发布的 Qwen3-Omni 全模态大模型。2025 年 3 月 27 日,阿里首次开源了其端到端全模态特大模型 Qwen2.5-Omni-7B,该模型支持多种输入形式,包括文本、图像、音频和视频(无音轨),并具备实时生成的能力,能够同步输出文本与自然语音的流式反馈(详细信息请参考:https://www.datalearner.com/ai-models/pretrained-models/Qwen2_5-Omni-7B)。根据官方透露,Qwen3-Omni 模型也已经完成训练,但是否会开源尚未确定。

此次发布的 Qwen3-ASR-Flash 模型专注于语音识别,构建于 Qwen3-Omni 之上。结合 3 月份开源的模型,我们可以 合理推测该模型很可能是 7B 规模的版本。

Qwen3-ASR-Flash 模型的显著特点包括:

- 能够识别 11 种语言(包括中、英、西、法、阿等);

- 在语音输入的基础上,支持通过prompt 输入以增强识别效果;

- 具备识别歌声中语音的能力;

- 可以处理带噪音的语音(如争吵、汽车和背景声等);

- 支持识别非语音片段:能够 忽略语音中的静默和背景噪声 等。

Qwen3-ASR-Flash 模型的 Prompt 增强能力

Qwen3-ASR-Flash 模型的一大亮点在于它支持基于文本与语音的输入,其中文本即为 Prompt。

根据官方描述,语音识别中存在一个难以克服的问题,那就是专有名词的识别。例如,某些特殊的地名和人名等,语音识别模型几乎难以准确识别。在这种情况下,只需在进行语音识别时向模型提供一些关键词,模型便能准确识别。

换句话说,Qwen3-ASR-Flash 支持 无须预处理上下文信息 ,便可实现 定制化语音识别结果。用户只需提供任何形式的“背景文本”,模型就能自动理解并据此调整识别结果(即“有偏转写”或“上下文引导识别”),从而更精确地识别特定的词汇、术语或语境内容。

支持的背景文本格式包括:

✅ 简单关键词列表:

["Qwen", "通义千问", "ASR", "Flash 模型"]

✅ 完整段落或长文档:

“本次会议将讨论 Qwen3-ASR-Flash 在医疗和金融场景中的应用,重点包括方言识别的鲁棒性和热词绑定能力。”

✅ 混合格式:

关键词 + 段落

["热词:科创板、北交所"] +“近期资本市场改革加速,北交所流动性提升明显…”

✅ 无意义 / 无关文本(不影响识别):

“香蕉在跳舞,月亮吃火锅”← 这类内容会被模型忽略,不影响正常的语音识别。

简单而言,若想让模型“偏向”识别某些内容,只需将相关文字输入模型 —— 不论内容多么杂乱,它都能智能识别重点,同时 不受干扰。

例如,在某个场景中,音频的正确识别结果应为“投行圈内部的那些黑话,你了解哪些?首先,外资九大投行,Bulge Bracket,BB …”。

如果不使用上下文增强,识别结果为:

投行圈内部的那些黑话,你了解哪些?首先,外资九大投行,Bird Rock,BB ...此处“Bird Rock”应被识别为“Bulge Bracket”。

而采用上下文增强(即将文字关键词与音频共同输入)时,投行公司名称的识别结果则正确无误:

投行圈内部的那些黑话,你了解哪些?首先,外资九大投行,Bulge Bracket,BB ...”这种结合 Prompt 的语音识别模型在实际应用中具有广泛价值,举例如下:

- 专业领域优化:可通过提供术语表显著提高医疗、法律、金融等领域的识别准确率。

- 品牌 / 产品名称绑定:输入公司名或产品名,避免误识别为同音的常见词。

- 灵活易用:无需复杂的预处理,业务人员可直接提交原始材料,降低使用门槛。

Qwen3-ASR-Flash 模型的识别错误率优于 GPT-4o 和 Gemini 2.5 Pro

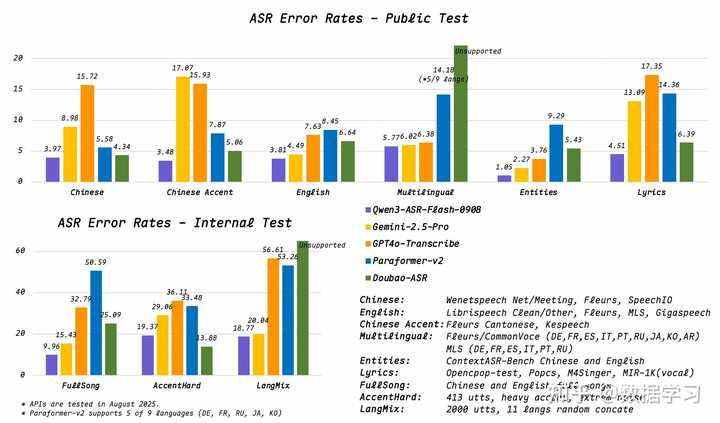

官方公开了 Qwen3-ASR-Flash 模型在多种语言上的语音识别错误率。这些数据通过以下图表展示:

从图中可以看出,Qwen3-ASR-Flash 模型在公开测试和内部评估中均表现优异,特别是在中文、带口音的中文、英语及多语言环境下,误差率明显低于主流竞争产品(如 Gemini-2.5-Pro、GPT4o-Transcribe、Paraformer-v2 和 Doubao-ASR)。在处理复杂的语音识别任务(如重口音、混合语言、歌曲识别)时,该模型展现出强大的鲁棒性,整体性能处于领先地位。尽管在某些特定场景(如多语言支持)上存在局限,整体表现依然突出,展现了其在通用语音识别领域的强大能力。

以“Chinese”和“Chinese Accent”两项任务为例,Qwen3-ASR-Flash 的错误率分别为 3.97% 和 3.48%(公开测试),远低于其他模型(如 GPT4o-Transcribe 的 15.72% 和 17.07%)。这表明该模型在中文语音建模方面表现出色,尤其在处理方言或非标准发音时能力卓越,适用于中国的本地化应用场景。

Qwen3-ASR-Flash 支持的语言种类

官方数据表明,Qwen3-ASR-Flash 能够在单一模型中对多种语言、方言及口音实现高精度的语音转写,具体支持的语言如下:

- 中文:涵盖普通话及主要方言,如 四川话 、 闽南语 、 吴语 、 粤语 等。

- 英语:支持 英式 、 美式 及多种地方口音。

- 其他语言:法语、德语、俄语、意大利语、西班牙语、葡萄牙语、日语、韩语、阿拉伯语。

总计支持 11 种语言,实用性极高。

Qwen3-ASR-Flash 接口能力概述及定价

目前,Qwen3-ASR-Flash 模型仅支持通过 API 访问,尚未开源。支持的输入形式包括 录音 URL、本地文件 及流式输入,支持的文件格式有 aac、amr、avi、aiff、flac、flv、m4a、mkv、mp3、mp4、mpeg、ogg、opus、wav、webm、wma、wmv。

需注意的是,Qwen3-ASR-Flash 模型为 单轮调用模型,不支持多轮对话和自定义 Prompt(包括 System Prompt 和 User Prompt)。

此外,当前模型的文本输入最大支持 10K 字符,音频输入限制为 10MB 或不超过 3 分钟,音频采样率为 16kHz。

官方给出的 Qwen3-ASR-Flash 模型定价为:文本输入免费,音频输入按时长收费,目前每分钟收费 0.00192 美元,折算下来约为 2 美分每分钟。值得一提的是,如果希望降低成本,可以 通过加速原始音频来减少费用!

Qwen3-ASR-Flash 模型综述

虽然阿里发布的 Qwen3-ARS-Flash 模型尚未开源,但其收费标准非常合理,且准确率令人满意!

更令人期待的是其背后的 Qwen3-Omni 模型,期待其相较于 Qwen2.5-Omni 能有显著提升,同时也希望能开源~

关于 Qwen3-ASR-Flash 模型的更多信息及在线测试地址,请参考:

https://www.datalearner.com/ai-models/pretrained-models/Qwen3-ASR-Flash