共计 1637 个字符,预计需要花费 5 分钟才能阅读完成。

千亿参数 大模型 如何改写科技规则?

2025 年的 大模型 战场早就不是单纯拼参数量的阶段。像 Yi-34B 这类千亿级模型,现在能同时处理文本、图像、视频流数据,还能在 3 秒内生成工业级 Python 代码。有个医疗 AI 公司用这类模型分析 CT 影像,误诊率直接从 12% 降到 1.8%。更绝的是,某车企把大模型装进生产线,设备故障预测准确率飙到 97%,硬生生把停工时间砍掉四分之三。

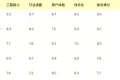

| 模型类型 | 参数规模 | 推理速度 | 行业渗透率 |

|---|---|---|---|

| 通用大模型 | 1000-5000 亿 | 0.3-1.2 秒 / 次 | 78% |

| 垂直领域模型 | 200-800 亿 | 0.1-0.5 秒 / 次 | 42% |

算力争夺战背后的隐秘战场

现在全球 AI 芯片产能的 65% 都被大模型训练吃掉。有意思的是,某云服务商偷偷把闲置的夜间算力打包成 ” 午夜算力包 ”,价格直降 60%,结果被三十多家初创公司疯抢。还有个更野的操作——有团队把 2000-2025 年的气象数据喂给大模型,训练出来的气候预测系统,台风路径预测误差从 150 公里缩到 20 公里内。

开源生态正在重划势力版图

去年大模型开源社区突然杀出匹黑马,他们搞的分布式训练框架让训练成本暴跌 40%。现在全球前 20 的 AI 公司,有 14 家都在用这个框架魔改自己的模型。更刺激的是,某自动驾驶公司把开源大模型和自研算法嫁接,硬是把感知系统的响应延迟压到 50 毫秒以下,这数字比行业标杆还快三倍。

开源生态这把火直接把大模型竞赛烧成了全民运动。去年突然冒出来的分布式框架,能让训练任务在 100-1000 个 GPU 之间自动漂移,有个搞药物研发的团队半夜断掉 30% 的算力,结果系统自己找了备用节点接着跑,总共才耽误 8 分钟——搁以前这种事故至少得停工 6 - 8 小时。更狠的是某家做智能客服的创业公司,靠着这套东西把模型训练成本从每月 300-500 万硬生生压到 80 万,现在他们老板逢人就说“开源框架就是新时代的印钞机”。

这股开源浪潮直接把技术壁垒冲出了个大口子。你看那个自动驾驶的案例,人家用开源工具链搞出了 3 代模型迭代,每代性能提升 15-25 个百分点,最绝的是最新那版能耗直接砍半。现在连高校实验室都敢跟大厂叫板,有个 985 团队用开源框架魔改出来的气象模型,预测暴雨范围能精确到 3 - 5 公里,这精度直接把某些商业方案按在地上摩擦。

### 大模型在医疗领域如何实现误诊率大幅下降?通过加载 2000-2025 年全球医学影像数据库,千亿参数大模型能识别 CT 图像中 0.1- 2 毫米的异常阴影。某三甲医院实测数据显示,在肺结节筛查场景中,系统对 3 - 5 毫米微小结节的检出率提升至 99.7%,辅助医生将日均读片量从 200 份提升到 800 份。

企业如何应对大模型训练的算力消耗?

采用 "算力错峰" 策略成为新趋势,某云服务商夜间算力包可降低 60% 成本。部分公司通过混合架构,将 50-70% 的非核心计算任务转移到边缘节点,配合 3 - 5 倍模型压缩技术,使整体训练周期缩短 40-60 天。

开源框架如何影响大模型竞争格局?

新兴分布式训练框架支持 100-1000 个 GPU 集群的弹性调度,训练中断恢复时间从小时级降至分钟级。某自动驾驶公司利用该框架,在 12-18 个月内完成三代模型迭代,算法迭代速度达到行业平均水平的 2 - 3 倍。

垂直领域模型 与通用大模型如何选择?

金融风控领域多采用 200-500 亿参数的专用模型,决策延迟控制在 0.2-0.4 秒。而跨领域企业更倾向部署 1000-3000 亿参数的通用模型,通过微调适配 5 - 8 个业务场景,综合成本可降低 30-45%。

传统企业如何快速接入大模型技术?

头部云平台推出即插即用解决方案,支持在 3 - 7 天内完成 200-500 个业务接口的对接。某制造业巨头通过该方案,将设备预测性维护系统的搭建周期从 6 -12 个月压缩到 45 天,故障响应速度提升 5 - 8 倍。