共计 2236 个字符,预计需要花费 6 分钟才能阅读完成。

在一场关于 AI 大模型 领域的求职面试中,气氛本就有些紧张。面试官经验丰富,深知要选拔出真正有实力的人才,就必须问出有深度的问题。于是,他抛出了一个关于

- BERT 的问题。

- BERT,在 AI 大模型 的分类中占据着重要地位。它是基于 Transformer 架构的预训练语言模型,在 自然语言处理 任务中表现卓越。面试官提出的问题,不仅仅是关于

- BERT 的基本概念,还涉及到它在实际应用中的优化以及与其他模型的对比。求职者们之前虽然都做了充分的准备,但这个问题还是让不少人心里一紧。对于 3. BERT 的深入理解,需要对 AI 大模型的分类和发展有全面的认识。

独特回答:展现专业素养

就在大家都有些不知所措的时候,一位求职者站了出来。他先是沉稳地思考了片刻,然后开始有条理地回答问题。

他详细阐述了

- BERT 在 AI 大模型分类中的位置。在预训练语言模型这个类别里,

- BERT 是具有代表性的模型之一。它通过双向编码的方式,能够更好地理解文本的上下文信息,这与一些单向编码的模型形成了鲜明的对比。在处理情感分析任务时,3. BERT 能够更准确地捕捉到文本中的情感倾向,因为它考虑了前后文的语义关系。

接着,他还谈到了

- BERT 的优化方向。随着技术的发展,

- BERT 也在不断进化。为了提高模型的效率和性能,研究人员提出了很多优化策略,比如对模型结构的调整、训练数据的扩充等。他以具体的实验数据为例,说明了这些优化策略是如何提升 3. BERT 在实际任务中的表现的。

深入对比:凸显

- BERT 优势

为了更全面地回答问题,这位求职者还将

- BERT 与其他相关的 AI 大模型进行了对比。

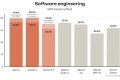

他制作了一个简单的表格来展示对比结果:

| 模型名称 | 编码方式 | 处理长文本能力 | 训练效率 |

|---|---|---|---|

|

双向编码 | 较强 | 适中 |

| GPT 系列 | 单向编码 | 一般 | 较高 |

| XLNet | 自回归双向编码 | 强 | 较低 |

从表格中可以清晰地看到,

- BERT 在双向编码方面具有独特的优势,这使得它在理解文本语义上更加准确。虽然在训练效率上可能不如一些专门优化过的模型,但它在处理多种 自然语言处理 任务时表现出了很好的通用性。

通过这样的对比,求职者进一步展示了自己对

- BERT 以及 AI 大模型分类的深入理解,他的回答赢得了面试官的点头称赞。

BERT 在自然语言处理领域那可是相当厉害,在好多任务里都有卓越的表现。比如说文本分类,它能够精准地把不同类型的文本划分到对应的类别中,就像给不同的物品找到各自合适的“家”。在情感分析方面,它能敏锐地捕捉到文本里蕴含的情感倾向,是积极、消极还是中立,都能判断得很准。命名实体识别也是它的强项,能准确识别出文本里的人名、地名、组织机构名等。还有问答系统,BERT 可以通过理解问题的上下文信息,给出合理且准确的答案。这都得益于它的双向编码方式,能够更好地去理解文本中上下文的信息,进而在这些任务中准确地处理和分析文本。

和 GPT 系列模型相比,它们的差别还是挺明显的。最主要的就是编码方式不同,BERT 采用的是双向编码,能把前后文的语义都综合起来考虑,就好比一个人在听故事的时候,前后的情节都能联系起来理解。而 GPT 系列是单向编码,就像是顺着一个方向去读故事。这样一来,BERT 在理解文本语义上就更准确,能够更深入地挖掘文本背后的含义。而 GPT 系列在生成文本时,因为它单向编码的特点,生成的文本连贯性比较好,读起来很通顺。在处理长文本的能力以及训练效率方面,两者也存在着差异。

要是想对 BERT 进行优化的话,有不少办法。一方面可以从模型结构调整入手,就像给一座房子调整内部的布局一样。比如对模型的层数、隐藏单元数量等结构参数进行调整,让模型的结构更加合理,能够更好地适应不同的任务。训练数据的扩充也很关键。可以收集更多、更有代表性的数据来训练模型,就像给一个人提供更多的学习资料,让它学习到更多的知识和模式,这样就能提高模型的效率和性能。

不过呢,BERT 在实际应用中也有一些局限性。首先就是训练成本比较高,这里面既包括计算资源的成本,也包括时间成本。训练 BERT 模型需要强大的计算设备和大量的时间投入。在处理特别长的文本时,它也会遇到挑战。因为随着文本长度的增加,它的计算复杂度会显著上升,就好像一个人在处理特别复杂的事情时会变得力不从心。而且,BERT 模型的可解释性比较差,我们很难清晰地说明它做出某个决策的具体过程,就像一个神秘的黑匣子,让人不太清楚它内部是怎么运作的。

常见问题解答

- BERT 在哪些自然语言处理任务中表现较好?

- BERT 在很多自然语言处理任务中表现卓越,如文本分类、情感分析、命名实体识别、问答系统等。它通过双向编码能更好理解文本上下文信息,从而在这些任务中准确处理和分析文本。

- BERT 与 GPT 系列模型的主要区别是什么?

主要区别在于编码方式,

- BERT 是双向编码,能综合考虑前后文语义;而 GPT 系列是单向编码。这导致

- BERT 在理解文本语义上更准确,GPT 系列在生成文本时连贯性较好。在处理长文本能力和训练效率方面也存在差异。

如何对

- BERT 进行优化?

可以从模型结构调整和训练数据扩充等方面进行优化。例如对模型的层数、隐藏单元数量等结构参数进行调整;收集更多、更有代表性的数据来训练模型,以提高模型的效率和性能。

- BERT 在实际应用中有哪些局限性?

- BERT 的训练成本较高,包括计算资源和时间成本。在处理特别长的文本时也会面临一定挑战,因为其计算复杂度随着文本长度增加而显著上升。而且模型可解释性较差,难以清晰说明其决策过程。