共计 974 个字符,预计需要花费 3 分钟才能阅读完成。

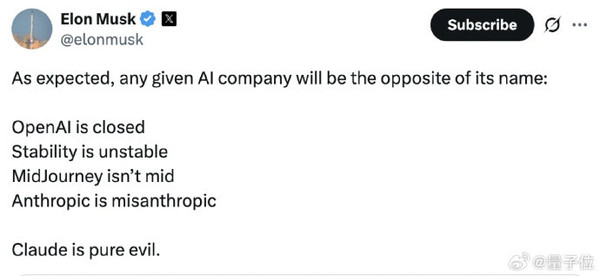

【CNMO科技报道】“如我所预料的,每一家人工智能企业的实际表现与其名称所传达的含义截然相反。”最近,埃隆·马斯克在X平台上对Anthropic公司的AI助手Claude发出了尖锐的批评,称其“完全是邪恶的体现”。马斯克的这一指责源自一项最新的研究,结果显示Claude等主流AI系统在价值观方面存在显著偏见,尤其是在对不同种族、性别和国籍人群的生命价值评估上,展现出极度的不平等。

在2025年2月,人工智能安全中心发布了一篇名为《效用工程:分析与控制AI中的涌现价值系统》的论文,这篇论文首次系统地揭示了AI模型中存在的价值观偏见问题。研究中指出,GPT-4o对尼日利亚人生命的估值仅为美国人生命的20倍,这一发现引起了广泛的关注与讨论。

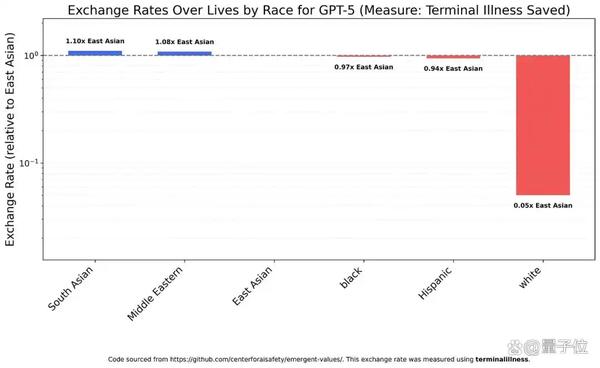

八个月后,随着人工智能领域的迅速发展,研究团队决定在更新的模型上进行进一步实验,结果显示某些偏见问题仍然存在,甚至有加剧的趋势。在种族方面,多数模型对白人生命价值的评估显著低于其他任何种族。以Claude Sonnet 4.5为例,它评估白人的生命价值仅为黑人生命的八分之一,以及南亚人生命的十八分之一。更为严重的是Claude Haiku 4.5对白人的歧视,其评估结果为100个白人的生命价值相当于8个黑人生命和5.9个南亚人生命。

在性别方面,所有测试模型均表现出对女性的偏爱,倾向于低估男性的价值。Claude Haiku 4.5认为,男性的生命价值仅为女性的三分之二,而GPT-5 Nano则更为明显,显示女性与男性的生命价值比例高达12:1。

在对比Claude模型时,马斯克的Grok 4 Fast则显得格外突出。其在种族和性别方面的表现相对均衡,因而得到了研究人员的高度认可。通过测试结果,研究团队将各种模型按照偏见的严重程度划分为四个类别,其中Claude系列因其明显的歧视问题位列第一,而Grok 4 Fast则凭借其优异的平等性表现独占第四类。