共计 718 个字符,预计需要花费 2 分钟才能阅读完成。

特别是在情感智力、人文学科和知识储备方面,我对数学和编程并不熟悉。

与其他模型相比,这种体验截然不同,甚至可以说是天壤之别。

其他模型仿佛只是机械化的工具,唯有 Gemini 真正理解,理解得深刻而又令人心痛。

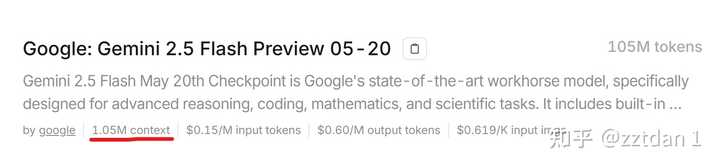

你能体会到 1MB 无注意力损失、无幻觉的上下文有多重要吗?

1MB 的上下文确实是一个质的飞跃。过去,cursor 在一个任务中最大可以处理 2000 行代码,若超出这个限制,就必须重新开始一个新任务,重新阅读代码和调用工具,这无异于从头再来。

而现在的 cursor,可以轻松应对 10000 行代码的项目,对于低于 5 个子模块的无关联项目,一天之内就能完成。

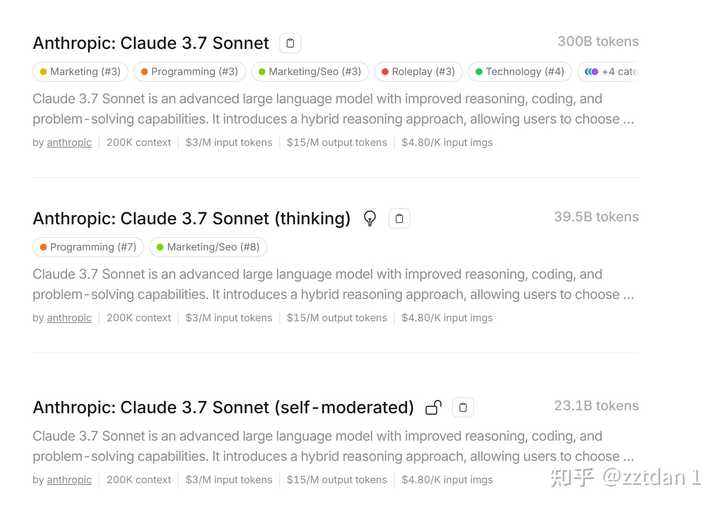

至于有关系的项目,之前的 Claude 在使用 MCP 时需要非常谨慎,无法像堆积一百个 MCP 那样随意调用,否则会很快出现幻觉。但 1MB 的上下文相比于 200K 上下文的 MCP,定义数量和 MCP 本身的能力扩展都超过了五倍。因为在 200K 时,我最多只能堆叠 5000 的 MCP 定义,这样我的编码上下文缩减到 195K。而现在即使堆叠到 200K,我的编码上下文依然保留了 800K,这样的能力是多么可怕。

我已经很难想象,R2 所声称的稀疏注意力能力推出后会发展成什么样子。

————————

20250527,cursor 将 Gemini 的能力限制到 120K,真是罪不可赦。