共计 4763 个字符,预计需要花费 12 分钟才能阅读完成。

Gemini Diffusion – Google DeepMind

大家好,我是来自中国人民大学高瓴人工智能学院的李崇轩。由于我在这个领域的工作与问题密切相关,因此愿意分享一些我个人的见解。

在与朱军老师及师弟师妹们的合作中,我参与了多个连续扩散模型的研究,代表性成果包括 Analytic-DPM、U-ViT、DPM-Solver、ProlificDreamer、DPM-Solver++、unidiffuser 等等。

虽然我在人民大学的研究组还很年轻,但在离散扩散模型方面,我们也有一些突出成果,例如 RADD、MDM 的 Scaling Law、LLaDA、LLaDA-V,以及即将发布的 LLaDA 1.5。

我想从时间的角度将这个领域分为两个阶段来进行介绍,同时也发表一些我的看法。

第一阶段:2022 至 2024 年底,扩散语言模型的基础研究阶段

在这一时期,扩散语言模型的研究相对小众,我将其分为离散和连续模型两种类型。

1.1 连续扩散模型在离散数据上的应用

早期有许多方法是将基于高斯噪声的连续扩散模型直接应用于语言模态,这可以被看作是对离散数据的一种连续化处理。代表性工作包括 Percy Liang、Ting Chen 与 Hitton 的合作、Quanquan Gu 和 Zaixiang Zheng 的研究,以及 Alex Graves 的贝叶斯流网络,此外,苹果的 Yizhe Zhang 和香港大学的 Lingpeng Kong 课题组也有很多相关工作(如果有遗漏,欢迎在评论区补充)。

还有一些研究采用连续模型,但避免了离散数据的连续化。例如,Lou 和 Ermon 的研究探讨了在单纯形空间约束下的离散数据概率分布的连续扩散模型,这虽然技术性较强,但可扩展性和采样方法较为复杂。

另外,ICML 2024 的一项研究提出了一种将 BFN 和扩散模型统一的方法,可以理解为在 logits 空间(softmax 之前)实施线性 SDE,这样既避免了数据的连续化,也不受单纯形的限制,同时可以借用 DPM-solver 等加速方法,我认为这个方法的构思非常巧妙。

我们课题组在扩散语言模型的研究起步较晚,大约在 2023 年 6 月开始,而上述的 ICML 2024 研究正是我们首个相关成果。我选择连续扩散模型的理由在于,它能够无缝集成多模态数据,语言、图像和视频的概率建模都可以统一为扩散模型,基于一个底层的 transformer 模型(类似 unidiffuser)来实现全面整合。

不幸的是,目前来看,这类方法在语言应用上的扩展性受到质疑,Plaid 的一些研究结果相对较为负面。不过,最近 BFN 在科学领域等小规模数据集上的应用却非常普遍,大家可以关注一些子刊的相关论文。

1.2 离散扩散模型的探索

追溯离散扩散模型,其实早在 ICML 2015 的 diffusion 论文发布时就已提出。Austin 和 Jonathon Ho 等人在 2021 年的 D3PM 可视为现代 MDM 的雏形,尽管其损失函数设计稍显复杂。Lou、Meng 和 Ermon 提出的 SEDD 进行了 EBLO 的优化损失,获得了 ICML 杰出论文奖(MDM 的相关工作较多,建议关注 DeepMind 的 Jiaxin Shi 和康奈尔的 Volodymyr Kuleshov 的相关研究)。

离散扩散模型的构建方式多种多样。其中一种知名方法是将词表上的平稳分布设为均匀分布,称为 Uniform;另一种则是全掩码的模型,称为 MDM(Masked Diffusion Model)。基于多项实验的结果显示,MDM 的性能显著优于 Uniform,而此时连续扩散模型的 scaling 也面临挑战。因此,研究者们的关注自然而然地转向了 MDM。

我们最初希望系统地理解 MDM 的本质。我们在 MDM 方面的首个重要发现让我颇感惊讶:一个 MDM 的转移核应该是一个关于 t 的函数(考虑到连续扩散模型需要将时间 t 输入网络进行去噪),然而,我们证明了 MDM 中这个函数关于 t 的部分可以被简化为一个有解析解的标量,并与一个需要学习的模型分布相乘。因此,我们可以对其进行重参数化,将 t 从模型输入中去除,最后在输出时再乘上去,这就是 RADD 的由来。基于 RADD,我们能够简化 SEDD 的模型和损失函数设计。例如,RADD 去掉 t 的设计意味着我们甚至不需要使用 Diffusion Transformer,而只需用普通的 Transformer,这自然地将其与 BERT、MaskGIT 进行了关联。

2024 年 6 月,我们的 RADD 工作发表于 arxiv(Your Absorbing Discrete Diffusion Secretly Models the Conditional Distributions of Clean Data),恰巧与我师弟 Deepmind 的 Jiaxin Shi 和康奈尔的 Volodymyr Kuleshov 同期发布。这三项工作的损失函数设计有相似之处,而我们的独特贡献在于证明了输入中 t 的冗余性,佳欣进行了调度的一般化与图文实验,Volodymyr Kuleshov 则实验验证了去掉 t 的有效性,并取得了优秀的语言结果。

2024 年 9 月,Kaiwen 的研究在 arxiv 上发布(Masked Diffusion Models are Secretly Time-Agnostic Masked Models and Exploit Inaccurate Categorical Sampling),再次证明了可去除时间 t,并特别指出了在 MDM 似然实验中的数值问题。

1.3 MDM 与 BERT 和 MaskGIT 的关系

由于这一问题备受关注,我特别单独进行回答。MDM 与 BERT 的关系如下:

MDM -> 采用 mask 转移核(不适用均匀分布)-> 证明其时间 t 在输入中是冗余的(否则使用 t 的话会变成 DiT/U-ViT)-> 输入随机掩码改为固定掩码(这样就不是生成模型)-> BERT

我们组的许多 MDM 研究人员背景都在机器学习,尤其是生成模型的领域,最初的动机是 MDM 本身是沿着概率建模的思路发展,因此顺理成章地称之为扩散(如果追溯到 ICML 2015,这比 BERT 还早)。后来我们确实发现了与 BERT 及 MaskGIT 的联系,这在相关工作中都有提及,并没有回避这一问题。

不过,我认为二者在技术上的区别是显著的,BERT 的联合概率是如何定义的?从 BERT 中采样文本的过程又是怎样的?如果没有这些能力,作为一个非生成模型,BERT 又如何与 GPT 一样统一语言任务呢?为什么有那么多 Scaling BERT 的研究,而它们仅作为嵌入模型而非基础生成模型?谷歌的 BERT 积累了多年,今天为什么 Gemini Diffusion 才问世?

实际上,具体的名称并不是最重要的,将 MDM 称为 Modified/Randomized BERT 从技术上讲并无不妥,但若将 Modified/Randomized 去掉,单称 BERT,是否就显得不够客观?

我个人认为使用“扩散”这一名称更为合适,这一路走来正是如此,技术上确实是扩散,并且突出其作为生成模型的特点,正因为它是生成模型,我们才相信它能够在扩展后与 GPT 竞争,而不仅仅是因为它类似于 BERT。

第二阶段:2024 年底至 2025 年初,扩散语言模型的扩展阶段

2.1 学术界的进展

随着 RADD 的问世,我感到这一领域的研究已经进入了一个新的阶段,因此决定将课题组的五位博士生一同投入到 MDM 的方向。2024 年我在启动小组会议时告诉大家,我们有 三个目标:

- 确保每位同学都能找到合适的 MDM 项目,进行系统的科研训练,确保大家都有机会成为第一作者(我已经实现了这一目标),不耽误大家的前程;

- 我们要团结一致,课题组共同开展一些有影响力的工作(这就是 LLaDA 系列的目标);

- 解决 MDM 中最具挑战性的问题,让顶尖公司在端侧或云端上线 MDM 模型或技术,击败 ARM(划掉)。

在这三个目标的引导下,我的课题组与合作者们开始从 MDM 的基础研究转向扩展研究。

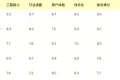

首个相关成果是我们在 2024 年 10 月完成的 MDM 扩展规律研究(ICLR 2025)。我们考虑了似然评估中的数值问题(之前提到过)以及在大规模应用中下游任务的重要性,进行了系统的 MDM 与 ARM 性能评测。尽管实验规模较小,但数据、算法、模型和计算量均进行了对齐,得出的结论解决了当时我们认为最重要的问题:在从头训练的情况下,MDM 在 GPT-2 规模下的表现与自回归模型相当。

第二个相关成果是我们在 2025 年 2 月完成的 LLaDA 8B,该模型实现了多轮对话能力。LLaDA 展现了出色的可扩展性和指令跟随能力,能够与 LLaMA 3 8B 等代表性工作相媲美,这进一步坚定了我们探索这一方向的信心。完成 LLaDA 后,课题组经过讨论,决定全力支持开源工作,尽可能将所有可开源的代码和权重发布,并及时回复社区内的各类问题。我们希望能够吸引更多的人加入这一领域,共同完善 MDM,进而实现我们的第三个目标。

后续的发展确实如我们所期待的,越来越多的人开始关注这一领域。近期,涉及语言对齐和推理的工作包括:d1、LLaDou,以及我们即将发布的 LLaDA 1.5(VRPO);在多模态相关的研究中,有王梦迪老师的 MMaDA、LaViDA 和我们的 LLaDA-V;在扩散技术上的类似 kv cache 加速技术也有 dimple 和 dLLM-cache 两篇研究。

此外,除了从头进行扩展,还有一条由 Lingpeng Kong 课题组进行的基于自回归模型微调的 diffuLLaMA 和 Dream 的研究方向。

2.2 工业界的成果

LLaDA 在 2 月份开源后,Inception Lab 迅速推出了 Mercury coder,5 月份 Gemini Diffusion 的发布也引发了广泛关注。然而,我们在 LLaDA 的开发过程中并未受到这些产品的启发,时间线清晰可见。

我认为,工业界的产品在许多方面肯定优于学术界的研究,他们在加速效果方面确实表现出色,使用了缓存、跳步和蒸馏等技术。但遗憾的是,目前二者都没有透露过多的技术细节。

关于 LLaDA 的贡献与局限性

LLaDA 是我参与过的最佳研究工作,尽管被 ICML 拒稿。从 2014 年开始读博至今,我在生成模型领域已经有十一年的研究经历,涵盖了 VAE、GAN、EBM 和扩散等多个方面。这一次,我终于能告诉别人这个研究是有效的,而不是别人告诉我。有人质疑 LLaDA 并没有新技术,老实说,我在生成模型的技术研究方面做过不少工作,比如 Analytic-DPM 就是一个技术导向的成果;而应用研究方面我也参与过很多,U-ViT 就是一个非常直接的例子。我认为,最优秀的研究不在于是否有新技术,而在于是否改变或深化了人们对某一领域的理解。LLaDA 的研究过程改变了我许多认知。

如果你觉得 LLaDA 没有带来认知上的变化,不妨问问自己,假设时间回到一年前,在 Diffusion 研究之前,你是否相信这条路会成功?如果给你 300 张显卡,只有一个半月的使用时间,你会如何利用这些资源?

很多人提到延长等问题,我认为这是一个非常敏锐的观察,这也是一个值得深入研究的课题。特别是对于从事研究的朋友们来说,如果一个问题被大家普遍认为简单,那么可能会竞争激烈。扩散语言模型仍然有许多值得探索的领域,机会往往隐藏在困难之中。

写到这里有些长了,感到疲惫。欢迎关注我们课题组在 2 月发布的知乎文章 GSAI-ML:自回归是否是通往语言智能的唯一路径?——生成模型的一些思考(3)