共计 2169 个字符,预计需要花费 6 分钟才能阅读完成。

在7月22日的凌晨,阿里巴巴通义千问团队发布了其旗舰模型Qwen3的重大更新,推出了新版本Qwen3-235B-A22B-Instruct-2507,取代了之前的非思考模式(Non-thinking)版本Qwen3-235B-A22B-FP8。

此次新版本的模型在多个核心能力方面取得了显著进展,不仅在性能上全面超越了Kimi-K2等顶尖开源模型,甚至在某些方面超越了Claude-Opus4-Non-thinking等领先的闭源模型。

那么,这次升级的性能究竟有多强呢?

根据官方发布的信息,新模型的通用能力得到了全方位的提升,在众多权威测评中表现非凡:

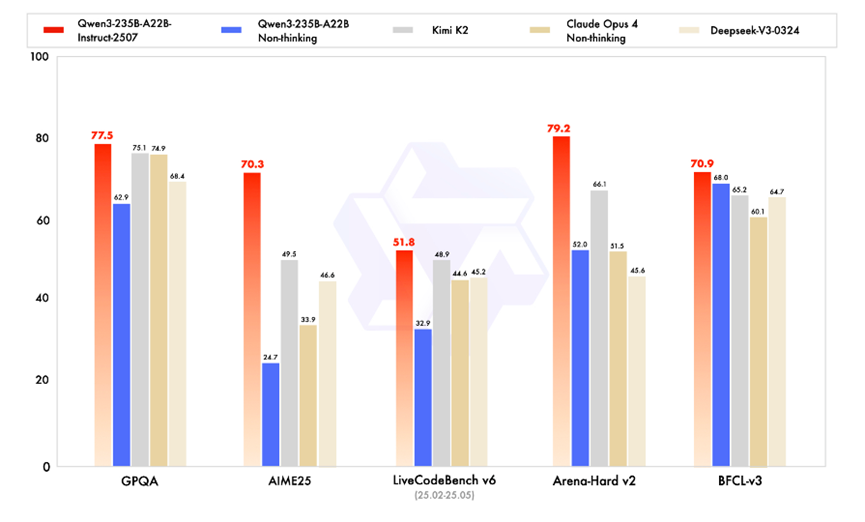

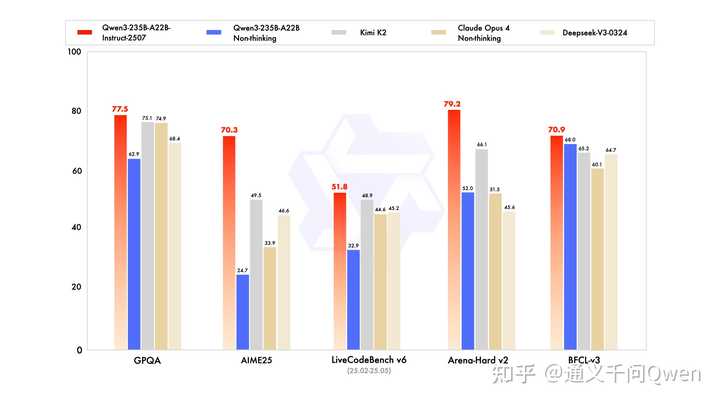

在指令遵循、逻辑推理、文本理解、数学、科学、编程及工具使用等方面,Qwen3在GQPA(知识)、AIME25(数学)、LiveCodeBench(编程)、Arena-Hard(人类偏好对齐)、BFCL(Agent能力)等多个测评中都取得了优异成绩,远超Kimi-K2、DeepSeek-V3等顶尖开源模型及Claude-Opus4-Non-thinking等闭源模型。

特别值得注意的是,此次更新的Qwen3模型在Agent能力方面表现尤为突出:在BFCL(Agent能力)测评中,模型表现出色。这表明模型在复杂指令理解、自主策划以及工具调用等任务的能力上,迈入了一个全新的阶段。“主打Agent”将成为未来AI应用的核心竞争力。

除了显著的性能提升,此次更新还带来了三大“体感”升级:

– 模型在多语言的长尾知识覆盖上取得了显著进展。

– 在主观及开放性任务中,模型增强了对用户偏好的契合度,能够提供更有针对性的回复,生成更高质量的文本。

– 长文本处理能力提升至256K,进一步增强了上下文理解能力。

那么,告别“混合思维”,分离训练又有多强呢?

此次更新的核心变化在于技术路线的重大革新。

通义千问团队宣布,正式终结过去的“混合思维模式”,进入全新的“分离训练”时代。他们对用于直接回答的Instruct模型和用于复杂推理的Thinking模型进行了独立训练。

简而言之,模型的“快思考”和“慢思考”各自发挥专长,从而在各自领域达到最佳表现。

本次发布的Qwen3-235B-A22B-Instruct-2507,正是“快思考”路径下的最新成果。它突出非思考模式(Non-thinking),追求在指令遵循、文本理解和知识问答等任务上,实现更快、更准、更强的表现。

https://baijiahao.baidu.com/s?id=1838305117657836324&wfr=spider&for=pc

经过与开发者朋友们的不断交流与深入思考,我们对非思考模式(Non-thinking)的旗舰版Qwen3模型进行了更新,推出了新模型Qwen3-235B-A22B-Instruct-2507,并同步开源其FP8版本。

新版本的Qwen3模型在通用能力上大幅提升,涵盖了指令遵循、逻辑推理、文本理解、数学、科学、编程及工具使用等多个方面,在GPQA(知识)、AIME25(数学)、LiveCodeBench(编程)、Arena-Hard(人类偏好对齐)、BFCL(Agent能力)等众多测评中均表现优异,超越了Kimi-K2、DeepSeek-V3等顶尖开源模型以及Claude-Opus4-Non-thinking等领先闭源模型。

此外,此次更新的Qwen3模型还在以下关键性能上得到了增强:

– 在多语言的长尾知识覆盖方面,模型实现了显著进展。

– 在主观及开放性任务中,模型显著提升了对用户偏好的适应能力,能够提供更具实用性的回复,生成更优质的文本。

– 长文本处理能力提升至256K,进一步增强了上下文理解的能力。

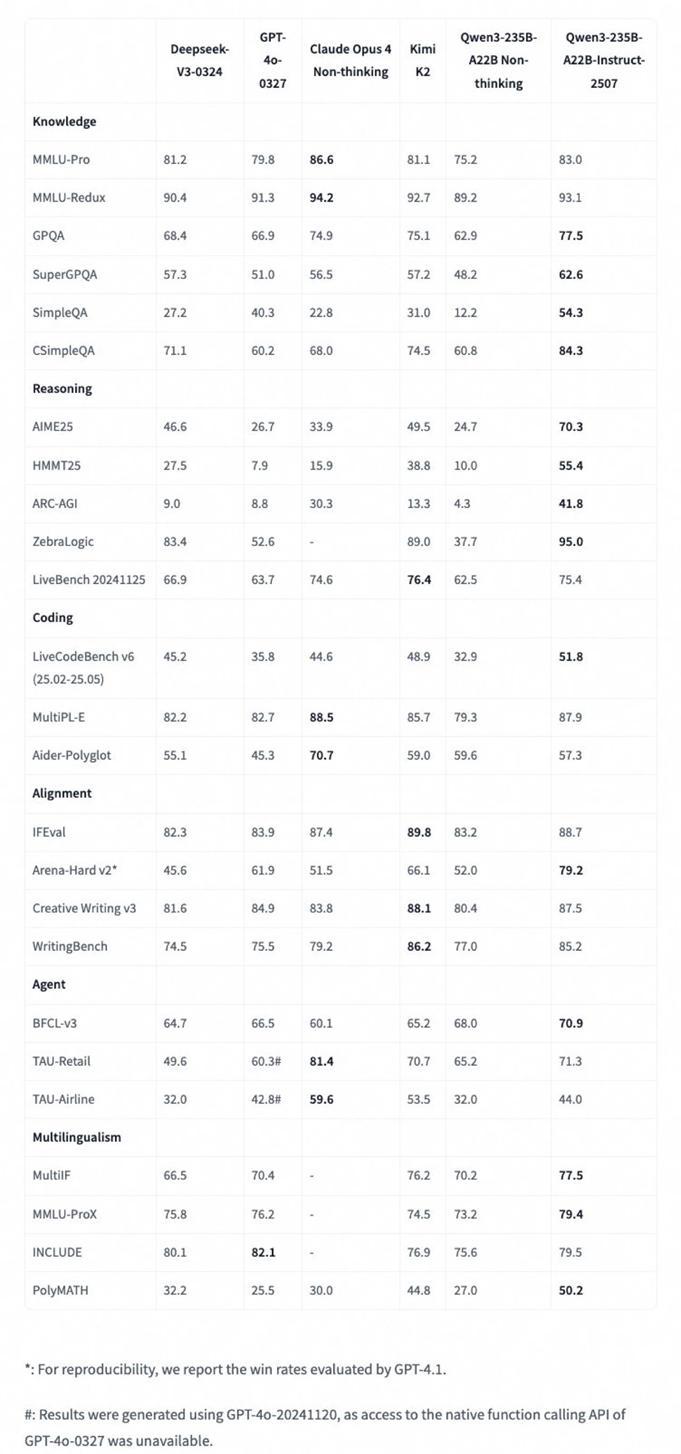

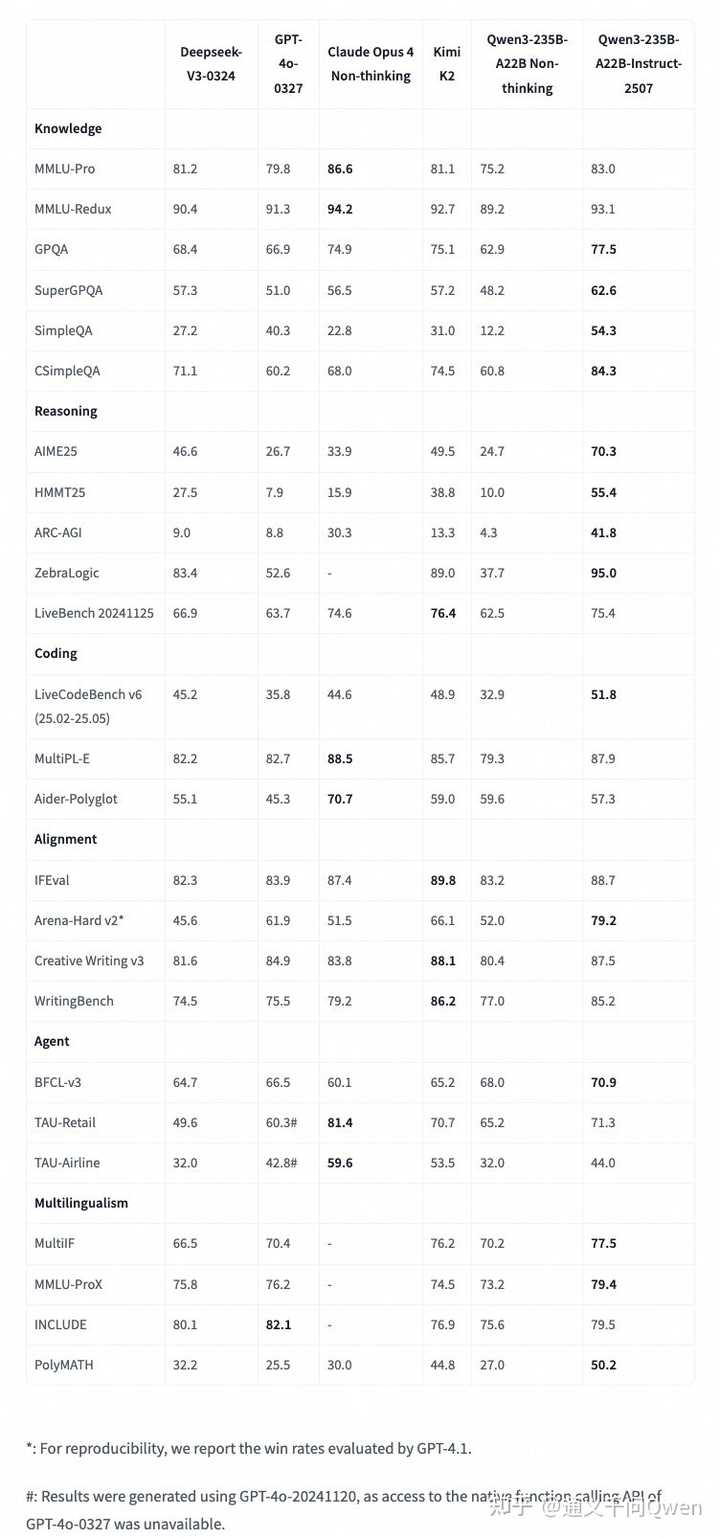

详细的测评结果请见下表:

此次发布的模型更加智能,知识覆盖面更广,能够完成更多任务,尤其在代理类任务中表现尤为突出,诚邀您亲自体验!

模型体验和下载链接:

Qwen Chat:https://chat.qwen.ai(默认使用新模型)

Hugging Face:

https://huggingface.co/Qwen/Qwen3-235B-A22B-Instruct-2507

https://huggingface.co/Qwen/Qwen3-235B-A22B-Instruct-2507-FP8

ModelScope魔搭社区:

通义千问3-235B-A22B-Instruct-2507

通义千问3-235B-A22B-Instruct-2507-FP8

模型评测结果请参见Hugging Face模型卡:

https://huggingface.co/Qwen/Qwen3-235B-A22B-Instruct-2507

更多精彩更新,敬请期待!

对于本次Qwen3的升级,大家有什么看法?欢迎在评论区留言或在话题下讨论,期待大家的反馈~