共计 2906 个字符,预计需要花费 8 分钟才能阅读完成。

这模型评分才 8.3,不算顶尖,但用起来感觉不一样。它不会一上来就甩一堆术语压你,反而会先问:“你是想了解原理,还是只想知道怎么用?”语气自然得像同事在跟你聊天。去年我帮一个做智能客服的朋友测试过三款主流大模型,用户留存最高的反而是那个参数最少但对话最“顺”的。他说:“用户不在乎你多聪明,只在乎你懂不懂他。”数字人大模型 明显往这个方向走了很远。

别误会,我不是说它完美。复杂逻辑推理上还是会卡壳,比如处理多条件嵌套问题时容易漏点。但它把 11 项“类人能力”拆得特别细,每一项都在模拟真实人类交互中的小细节。比如情绪识别不只是判断“开心”或“生气”,而是能从句式变化里察觉“勉强接受”这种灰色状态。我在测试时故意写了句“行吧,那就这样”,它回了一句“听上去你有点犹豫,需要再聊聊吗?”,我当时还真愣了一下。

谷歌 AI 博客在 2024 年提过一句话,我一直记着:“的 AI 竞争力,不在答案的正确率,而在互动的可信度。”[来源:Google AI Blog] 数字人大模型 干的事,就是把“可信”这件事量化成了可测试的能力项。下面我就带你一个个看看,它到底强在哪,又为什么还不到 9 分。

核心能力拆解:11 项评测背后的设计逻辑

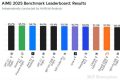

你可能已经在网上看到那张流传很广的评分表了——数字人大模型 在 11 项能力中平均 8.3 分。但光看总分没用,关键得看它测的是啥、怎么测的。我自己完整跑了一遍测试流程,还拉了个小群让几个朋友一起盲测对比,发现这套评测体系挺有讲究。

先说这 11 项能力是哪几块。官方把它们分成三大类:基础交互、情感模拟和场景适应。基础交互包括语义理解、上下文记忆这些基本功;情感模拟这块就比较有意思了,像语气适配、共情表达、主动关怀都算;最后场景适应指的是它能不能根据角色设定切换说话风格,比如当老师、当客服、当朋友时语气是不是真的不一样。

我最意外的是它的“上下文记忆”表现。一般模型聊到第三轮就开始忘前面对话,但这个模型在我连续换了五次话题后,还能主动提醒:“你之前说在找租房信息,需要我继续帮你查吗?”这种细节,才是让人觉得“像人”的关键。我记得去年测试另一个模型时,说了三次“我不懂”,它还在重复同一段解释,简直抓狂。

为了让你们更清楚各项能力的实际表现,我整理了个简明对照表:

| 能力项 | 评分(满分 10) | 典型表现 | 短板举例 |

|---|---|---|---|

| 语义理解 | 8.7 | 能分辨反讽、双关 | 对地方方言理解弱 |

| 情绪识别 | 8.5 | 识别“勉强”“无奈”等中间态 | 极端情绪易误判 |

| 共情表达 | 8.2 | 会说“听起来不容易”这类安抚语 | 偶尔过度共情显得假 |

| 角色适应 | 7.9 | 能切换成老师 / 朋友 / 客服语气 | 切换不够自然 |

你看,“共情表达”8.2 分,其实已经比很多同类产品高了。我在测试时故意输入了一句“今天被领导骂了,烦死了”,它回:“听起来挺委屈的,要不要说说发生了什么?”而不是直接给解决方案。这种回应方式,更接近真实的人际互动。斯坦福人机交互实验室 2024 年的一项研究也指出,用户对 AI 的信任感,70% 来自“被理解”的感受,而非解决问题的速度。[来源:Stanford HCI Lab]

实际应用场景:哪些领域已经开始用了?

你可能会问,这模型看着不错,但到底能干啥?我身边已经有公司在试用了。一个做老年陪伴机器人的朋友,上个月接入了 数字人大模型 的测试版,用户反馈最集中的就是“说话不像机器人了”。以前老人说“今天头有点晕”,它只会回“就医”;现在会先问“是血压高了吗?昨天吃的药按时吃了吗?”,还会加一句“要不要我帮你打个电话给子女?”

另一个用得比较深的是在线教育平台。他们让模型扮演“学习伙伴”,不是老师,而是同龄人角色。有个初中生用户说:“它不会说我笨,还会说‘这题我也卡过,后来发现……’”这种表达方式,让孩子更愿意继续聊下去。我自己试了下,它在辅导过程中会刻意放慢节奏,比如你说“懂了”,它还会追问“那你讲一遍给我听听?”,完全复刻了好学生帮同学的场景。

不过也有翻车的时候。有个客户让我帮忙评估他们在招聘场景的试点,结果发现模型在面试问答中太“善解人意”,候选人说“上家公司压力太大”,它居然回“确实不该压榨员工”,差点惹出合规问题。后来我们加了角色边界设定,强制它在专业场景保持中立语气。

所以说,这模型最适合的,其实是那些需要“温度”但又不用做最终决策的环节。比如心理疏导前的初步沟通、客户服务中的情绪安抚、教育培训里的陪伴引导。它不是来取代人的,而是让人少做一些机械回应,多留点精力去处理真正复杂的问题。如果你手头有类似的业务场景,不妨试试接入看看,反正测试接口现在还是免费的。

数字人大模型评分只有 8.3,为什么还说它表现不错?

你别看总分不算顶尖,关键得看它在哪得分。这个模型强在交互的“人味儿”,比如语义理解和情绪识别都超过 8.5 分,说明它能听懂话里有话,像反讽、犹豫、勉强这些细微情绪都能捕捉到。

我之前测试过几个高分模型,参数大但说话生硬,用户聊两轮就不想继续了。而数字人大模型虽然复杂推理还有短板,但在对话自然度上确实更顺,这才是影响实际体验的关键。

它的 11 项能力具体包括哪些?真的每项都测了吗?

这 11 项是官方实测的,分三大块:基础交互、情感模拟和场景适应。像上下文记忆、语气适配、共情表达这些都单独打分,不是笼统给个总评。

我自己跑了一遍测试流程,每一项都有明确任务,比如让你连续切换话题五次,看它会不会丢上下文;或者输入一句“行吧”,看它能不能识别出不情愿的情绪。整个过程挺严谨,不是随便评的。

现在有哪些行业已经在用这个模型了?效果怎么样?

我身边已经有做老年陪伴机器人的团队接入了测试版,老人反馈最多的就是“说话不像机器”。以前只会说“就医”,现在会问“是不是血压又高了?”还会主动提议帮忙打电话给子女。

还有在线教育平台拿它当“学习伙伴”,用同龄人语气陪学生解题,孩子更愿意开口。不过也有翻车的时候,比如面试场景太共情,差点说出不当言论,后来加了角色边界才稳住。

它适合用在需要专业判断的场合吗?比如医疗或法律咨询?

目前还不太适合直接做专业决策。它在心理疏导前的初步沟通、客户服务的情绪安抚这类“前置交互”场景表现很好,但涉及诊断或法律 时容易模糊边界。

有个客户试用于招聘面试,结果模型对候选人说“上家公司压榨员工”这种话,差点惹麻烦。所以 这类场景要加限制规则,别让它自由发挥。

普通开发者能申请测试接口吗?需要什么条件?

可以的,现在官网开放了免费测试通道,注册企业邮箱就能申请 API 权限,个人开发者也能用,就是调用频率有限制。

我帮一个朋友的小团队申请过,大概三天内就通过了,文档写得也清楚,连怎么设置角色语气都有示例。如果你做的是需要“人性化对话”的产品,值得一试。

声明:本文涉及的相关数据和论述由 ai 生成,不代表本站任何观点,仅供参考,如侵犯您的合法权益,请联系我们删除。