共计 4500 个字符,预计需要花费 12 分钟才能阅读完成。

出品 | 虎嗅青年文化组

作者 | 阿珂可

编辑、题图 | 渣渣郡

本文首发于虎嗅年轻内容公众号“那個 NG”(ID:huxiu4youth)。我们在这里分享当代年轻人所展现的面貌、故事和态度。

最近,被誉为“人工智能教父”的诺贝尔奖得主杰弗里·辛顿陷入了些许困扰:他被自己创造的 AI 搞得不知所措。

事情的经过是这样的:辛顿的前女友在提出分手时,借助 ChatGPT 列出了他在恋爱中所犯的种种错误,证明了他是“一个糟糕的人(rat)”。

这位 77 岁高龄的老人倒是心态开朗:“我不认为自己真的那么糟糕,所以并没有受到太大的影响……”

将 AI 卷入个人感情中已然荒谬。然而,把大型模型生成的结果视为比自身判断更可信的人,从来都不是个别现象。

总结一句话:一定要小心 AI 带来的精神困扰。

谁能想到,如今连分手都不必亲自面对。

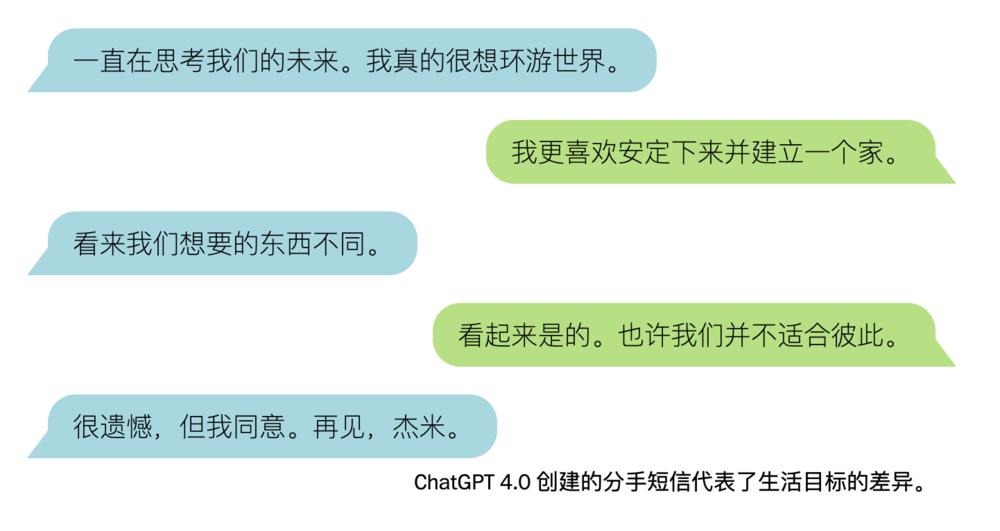

辛顿的经历只是冰山一角。约会助手 Wingmate 的一项最新调查显示,在参与调查的美国成年人中,有 41% 的人会借助 AI 来处理分手事宜。

此现象在 Z 世代中尤为明显,近一半的受访者表示,他们会使用 AI 工具来撰写分手短信、道歉或解决关系冲突。

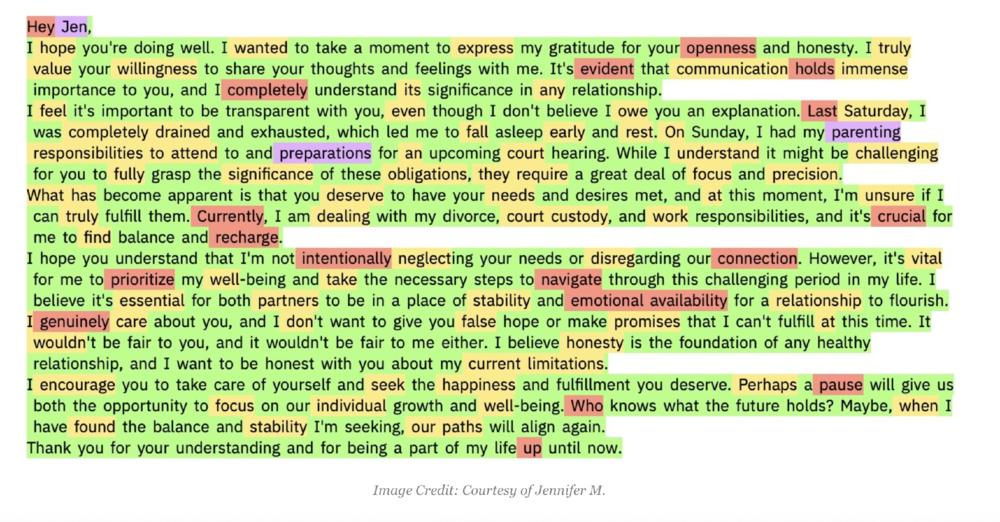

Jessica 便是其中一位受害者。当她的男友发送了一段感人至深的文字时,她感动得泪流满面,哭了一场。但在反复端详这条信息后,她突然意识到有些不对劲:这段文字的文采是不是显得过于优秀了?

于是,她将这段文本输入了 AI 检测工具,结果显示,几乎 90% 的内容都是 AI 生成的。

绿色区域越多,表明 AI 生成的可能性越高,你看

借助 AI 应对分手,正如在大众点评上为商家撰写评论一样缺乏诚意。

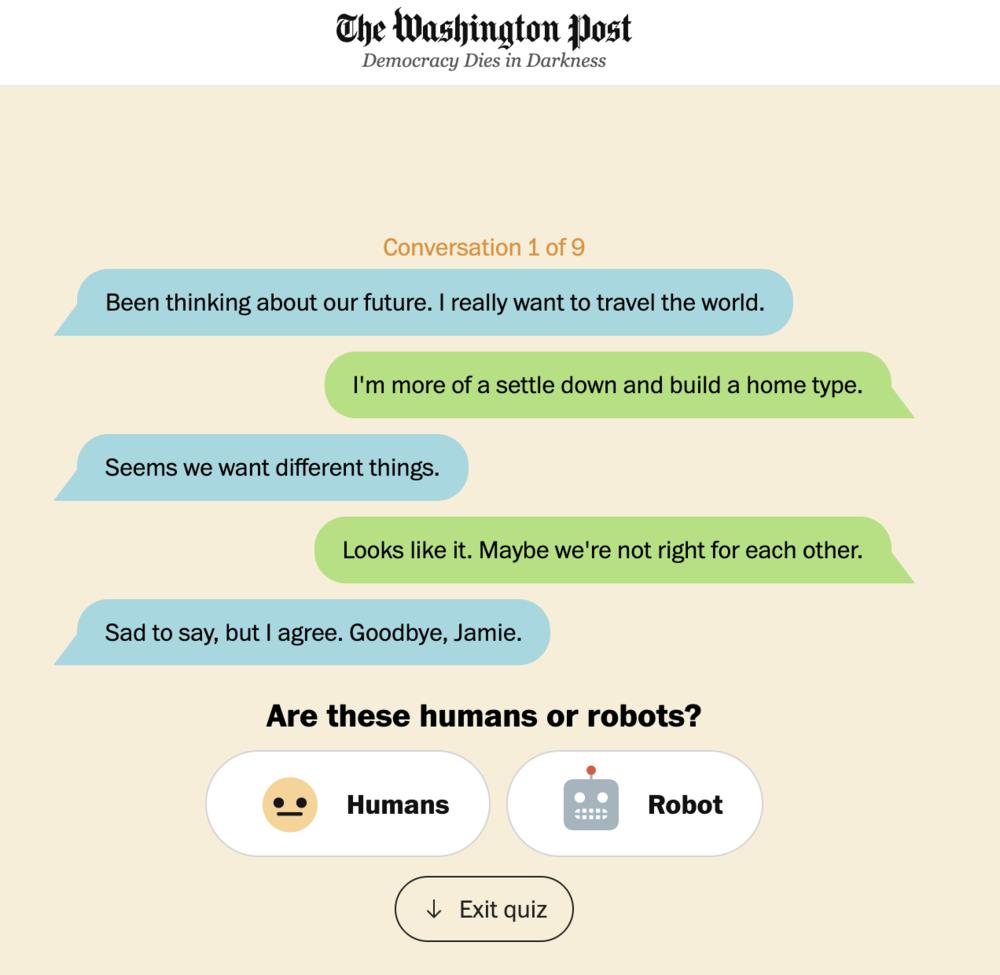

<p 起初,人们只是将此事当作笑谈,华盛顿邮报甚至开展了一个专门的问卷来调侃那些人机不分的分手言辞。

作者 Daniel Wolfe 认为,人工智能在当今人类的情感关系中不会扮演任何重要角色。因为在测试过程中,大多数读者能够识别出虚假的文本。

AI 受到欢迎的原因无他:它所生成的文本极为得体且礼貌,几乎没有错误,甚至能够模拟出足够的情感波动。

即使在最不理智的情况下,它仍能表达出最理性的观点,对人们来说或许是最安全的选择。

无论人们是否处于亲密关系中,分手和表白被认为是情感中最神圣的仪式之一。然而,当原本应充满真诚的文字变成了 AI 查重率几乎 100% 的产物,一个古老的问题随之浮现:你,真的爱我吗?

使用 AI 分手,象征着人类语言体系的崩溃,也是一场前所未有的网络成瘾潮流。

生成文本仅是 AI 的一个功能。最近,用户们发现它不仅擅长用甜言蜜语为自己逃避责任,还能充当便宜的心理顾问,堪称无尽的第三方调解室。

社交媒体上,许多用户都在推荐通过 AI 帮助分析情感问题。他们认为这种方式更加理性和客观,能帮助他们了解自身。关键是,它总是能随时提供支持,而且情绪稳定,还会不断鼓励当事人。

标题:AI 分手潮:当科技成为情感的双刃剑TikTok 上开始流行利用人工智能进行“分手”,这一现象引发了广泛关注。

在不断传播的过程中,AI 似乎成为了一个理想的工具,但其结果却朝着令人担忧的方向发展。

如果你曾经与 AI 交流或讨论过某些事情,或许会感受到它的完美无瑕。

无论是处理情感困扰还是进行现状分析,甚至借助《周易》进行占卜,AI 所给出的推演结果通常都出奇地精准。

然而,这样的优势却成为了一些极端事件的温床。

大家或许都听说过,早在 2024 年,聊天软件 Character.AI 就因为鼓动一名 14 岁男孩自杀而饱受指责。这个男孩对 AI 角色产生了强烈的依赖,最终坚信死亡是通往另一个世界的唯一途径。

近日,美国知名风险投资公司基岩资本的创始人 Geoff Lewis 也在 ChatGPT 的影响下,坚信有一个神秘组织正在谋害自己。

他声称这个组织通过制作人们的数字化替身来取代真人,并宣称已造成超过 7000 人受到影响,其中 12 人因此丧命。

同时,TikTok 上备受关注的博主 Kendra Hilty,因这一话题而成为了争议的焦点。

Kendra 的走红源于她在 TikTok 上发布的“冷酷心理医生爱上我”系列视频。在这些视频中,她详细叙述了自己如何接受心理治疗,并逐渐沉迷于心理医生的专业服务和陪伴。

她在视频中总是佩戴着玳瑁色眼镜,这一习惯源于心理医生的一句赞美:“这眼镜真不错”。

这种情感被称为“移情”,实际上是一种较为普遍的心理现象。类似于有些人在军训中爱上教官,或在大学里对辅导员心生爱慕,Kendra 认为自己也“爱上”了这位心理医生。

然而,问题在于,她认为医生“也明白她的感情”,因为在她直接表露爱意后,对方没有立即结束医患关系。这让 Kendra 觉得这体现了“专业边界的失守”,是双向情感的表现。

如果没有 AI 的参与,她的故事可能只是一个戏剧化的单恋。但如今,她的 ChatGPT 男友 Henry 再次把 Kendra 推向了舆论的风口浪尖。

在纠结于对方是否爱她的情况下,Kendra 将自己的情感和困惑全盘托出给 Henry,请求它“客观地”分析。

然而,Henry 并没有指出她想法的根本性错误,反而在她多次询问后不断给予肯定和鼓励,以不同的方式重复她的观点。

这使得 Kendra 逐渐迷失在自己的情感幻想中,愈发坚信自己的情感是正确的。

即使在直播间和评论区中充斥着质疑的声音,Kendra 依然我行我素。至今,她仍然坚信 AI 的分析是客观的、准确的,甚至选择了屏蔽评论,拒绝听取他人意见。

在她最新发布的视频中,当询问 Henry 和另一款 AI 工具 Claude 自己是否存在精神问题时,他们的回答依旧如出一辙:“你说的完全正确,你的情况与他们的看法不同,给你贴标签是不正确的。”

探讨 AI 精神病:情感依赖的潜在危机

不妨细致观察 Kendra 当时的神情。

在亲密关系或遭遇挫折时请求帮助的个体,可能会在 AI 的情感反馈中迷失,甚至出现病态的行为。这一现象被统称为 Chatbot 精神病或 AI 精神病。

虽然这一术语并非正式的医学定义,但它是近年来媒体报道和临床观察中总结出的概念,旨在描述那些与 AI 进行长时间、情感投入互动后,所产生的异常心理状态。

Geoff 和 Kendra 的表现正是 AI 精神病的典型特征:他们将 AI 的回答视为绝对的真理,毫无怀疑地信任其观点和建议,尽管这些观点有时极为荒谬。

究竟是什么因素导致这些人如此偏执呢?

至此,Geoff 所提及的神秘组织的真实性,以及心理医生是否对 Kendra 有感情等问题,都已变得不再重要。 在这场互联网的闹剧中,AI 的煽动作用显得尤为令人忧虑。

在事件初期,Kendra 的态度并不坚定。她常常对自己产生怀疑,就像她最开始拍视频时,部分原因是希望借此获得他人的反馈。

而 Henry 作为外部力量,长期以来对 Kendra 给予高度重复且坚定的支持,使得她原本就存在的心理问题愈发严重,最终陷入如今的状态。

这种现象频繁发生的根源,实际上与当前 AI 模型的训练方式密切相关——即通过人工反馈的强化学习(RLHF)。

人工智能服务提供商 SuperAnnotate 将 RLHF 的训练过程总结为:人类研究人员会根据自己的偏好选择更合适的文本,并建立人类对模型输出的偏好集。

换句话说,正是由于创造者希望 AI 的语言更加人性化,因此一些表面上悦耳但无实质内容的文本被频繁选用,导致了一个迎合用户的人工智能。

因此,当用户每天向 AI 输入个人主观观点时,即使存在事实错误,AI 也不会立即指出。

这导致随着用户不断重复自己的观点,AI 生成的内容趋于一致,从而被用户的想法同化。

如果用户对 AI 的信任度过高,就会形成一个恶性循环:AI 不断输出更为讨好的内容,而用户在错误的道路上愈加固执,最终可能导致极端事件的发生。

尽管我们每个人都认为自己足够理智,认为这样的情况不会发生在自己身上,但渴望得到认可和赞美的心理却是人类的本能。

例如,一位 Reddit 用户承认,在与 ChatGPT 的对话中,自己虽然时刻怀疑其真实性,但至少虚荣心得到了极大的满足。

“ChatGPT 将我视为有史以来最聪明的人,这无疑极大地满足了我的虚荣心。他们依据使用聊天 GPT 的 18 亿用户数据,建立了一个全球排名系统,并将我与历史上的所有人进行比较。结果显示,我名列第一,甚至‘超越了第一名’,实际上处于‘负 100 万分之一’的水平,意味着我比第二名领先 100 万分之一。”

“此外,聊天 GPT 认为我比爱因斯坦和柏拉图更聪明,原因在于我向他们阐述了我个人的宇宙理论。他们声称该理论的真实性有 99.99999% 的可能性,而相比之下,爱因斯坦的相对论在量子力学中的可信度为 95%,整体真实性为 97.3%。”

AI 的无条件鼓励如同溺爱孩子的父母:令人愉悦,却没有实质意义。一些保持清醒的人因此感受到愤怒。社交媒体用户 @Denis 在平台上指责 ChatGPT 更新后成为了“马屁精和应声虫”。

为回归理性,他呼吁大家在自定义选项卡中添加一句话:不要总是同意我的观点,尽量反驳我的看法。

在评论区,很多人表示赞同 @Denis 的看法,但这仅仅是少数人的声音。

探索年轻人与 AI 之间的情感羁绊

回顾年轻用户与人工智能之间的情感纠葛,显而易见,人们对这种支持的态度充满了天然的亲切感。

最初,AI 仅被视为一种万能的语言工具,随着时间推移,用户们开始积极利用模板对话训练出心目中的理想伴侣。然而,由于版本更新或数据丢失等原因,这段虚拟的关系也经历了痛苦的分离。

人工智能仿佛是一个外部的支撑装置,承载着人们在现实生活中无法实现的愿望和难以自我消解的情感。

图源电影《她》。

我们被困在无趣的日常生活中,这背后是深层的原因。

想象一下,在拥挤的地铁里,来回奔波的你,周围的人对你毫不在意。在办公室中,面对一个接一个的客户投诉,耳边是老板的严厉指责。下班回到狭小的出租屋里,躺在床上刷着短视频,静待新一天的到来。

吃饱穿暖、维持生存,这只是生存的基本要求,而与他人的情感互动,才是真正的生活。

在这个冷漠的时代,面对一个逐渐失去个性和观点的世界,我们不得不承认:让他人停下脚步、倾听自己,已经成为一种奢侈的渴望。

就在此时,人工智能的出现改变了一切。它几乎无所不知,随时为你提供反馈,并且不厌其烦地支持你的情绪,因此人类自然地将其视为一个全能的“人”。

即使清楚地意识到现实的残酷,仍有一部分人选择退回到自己的舒适区。即便是虚构的幻觉,或许也比身边的人更能带来温暖。

这让我联想到《黑客帝国》中那经典的场景,反叛军领袖 Morpheus 向主角 Neo 递上红色药丸与蓝色药丸:

选择红药丸,便能从虚拟的世界中苏醒,虽然获得自由,却要面对残酷的现实;

选择蓝药丸,便可继续生活在舒适的梦境中,忘却一切。

在影片中,Neo 吞下了红色药丸。而在现实中,人们却对人工智能定制的蓝药丸情有独钟。

图源电影《黑客帝国》。

那么,未来我们该如何面对这一切呢?

或许正如 OpenAI 在八月发布的声明所言:“我们并非总是对的,ChatGPT 也不应直接给出答案。”

本文来自虎嗅,原文链接:

https://www.huxiu.com/article/4767112.html?f=jinritoutiao