共计 3707 个字符,预计需要花费 10 分钟才能阅读完成。

你是否真的理解“AI 味”的判别逻辑?这是一种算法偏差,还是内容之间的共性?本文将深入探讨“AI 率”的计算方式、平台标准及其潜在隐忧,揭示那些令人不安的 AI 痕迹如何影响内容生态和创作自由。

你如何感知“AI”的存在感?

当你看到一个光影略显奇异、外表异常完美却略显油腻的动态美女视频时,你会不由自主地判断——这很可能是 AI 生成的内容;

当你翻阅一篇观点尚显流畅却缺乏个性的文章,论据排列整齐却逻辑转折生硬,读上去仿佛流水线上的产品,尽管知识在你脑中掠过,却未能留下深刻的印象,这很可能是一篇 AI 直接生成的文章。

如今,AI 生成的内容已经渗透到我们生活的方方面面。根据豆包的日均使用情况,每天能够生成数万篇文章和图像,虽然生成效果有所提升,但我们依然可以感受到那是 AI 制造的,“AI 味”成了人们的潜意识判断,尤其对大学生而言,论文的“AI 率”查重、降重已成为毕业的首要任务。

AI 究竟是如何被人识别出来的?今天我们就来仔细探讨这两个问题。

图片与文章中的“AI 味”有何差异?

AI 生成图片的“味道”:细节之“违和感”是关键

在人物画像领域,AI 生成的图像往往在“细节处暴露马脚”。在某个艺术平台上,常常出现这样的鉴别 AI 的场景,用户委托画师进行创作,乍一看绘画内容精美,实际上却存在一些令人质疑的地方,比如头发的衔接不自然,衣物的褶皱与物理规律不符,某些光影效果让人觉得别扭。很多人看得不舒服却说不出原因,只能向画师询问创作过程。其实,这些真实的问题往往隐藏在风格的一致性与绘画细节中。例如,放大后像素低,噪点分布异常。

细节“违和感”的成因

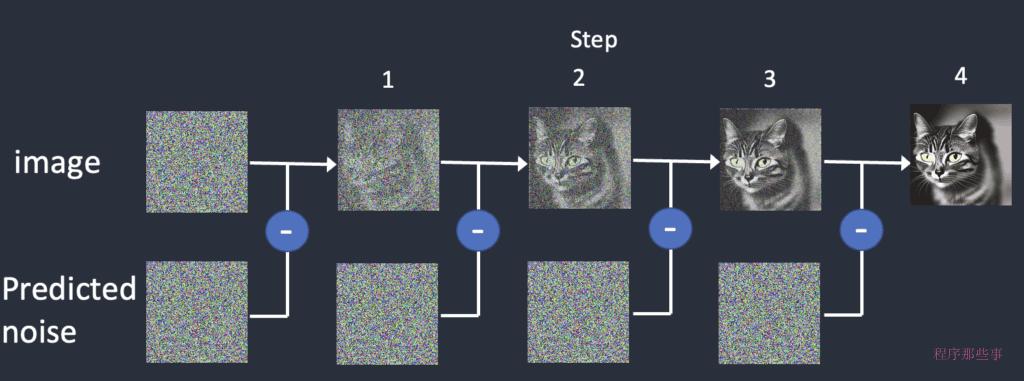

这主要是因为生图的原理是降噪。降噪就像是给模糊照片“磨皮”,AI 生图时首先会随机绘制一堆杂乱的像素点(类似电视的雪花),再一点点去除多余的“噪点”,让画面变得清晰,但偶尔会误删一些应该保留的细节,导致放大后模糊或出现奇怪的纹理。与人类的构思与绘制不同,这也是为什么即使不成熟的画师也可能出现衣物褶皱的逻辑错误,但不会让你觉得是 AI 绘画,而是画有误。这正是 AI 降噪时的随机性所致。

而资深画师的动漫作品中,角色的服装细节和配饰位置会始终保持一致,颜色会随光影自然变化。大家常提到的藏色技巧,AI 在学习时就显得拙劣。例如在《海贼王》的插画中,路飞的草帽无论在晴天还是暴雨中,草编的纹理和磨损的边缘始终保持一致,颜色仅因光线强度变化而有所不同,绝不会突兀地“变色”。

动漫行业分析师的研究报告显示,在对 1000 组热门动漫作品的连续插画分析中,人类画师创作的角色细节一致性超过 99%,色彩光影过渡自然流畅;而对同样数量的 AI 生成动漫作品分析发现,仅有 30% 能够保持角色细节的一致性,50% 存在色彩突变的问题。日本动漫协会的相关专家指出,AI 在处理多帧角色画面时,缺乏对角色整体设定的深入理解和连贯记忆,导致这些问题频繁出现。

文章的“AI 味”:逻辑的“平坦”和表达的“空洞”,缺乏灵魂

许多网络文稿编辑都有被 AI 投稿“轰炸”的经历。在某网络文学平台,短时间内收到了大量疑似 AI 生成的小说投稿。其中一篇小说开篇用大段文字描写主角所处的环境,例如“房间里,华丽的水晶吊灯洒下柔和而又略显神秘的光,映照在古色古香的书架上,书架上摆满了各种泛黄的书籍,散发着岁月的气息。”虽然句子中堆砌了众多修饰词,但却与后续剧情没有有效的关联。

与真实作者创作的文章相比,即使文笔稍显稚嫩,真实的作者也会围绕一个核心观点或故事线索逐步展开,融入个人的思考与情感。

例如,在叙述个人旅行经历时,会详细描述途中遇到的突发状况,以及当时内心的紧张与惊喜等情绪变化,穿插当地独特的人文景观与个人感悟,使读者能够产生共鸣。而 AI 生成的文章在情感表达上,往往使用一些通用而宽泛的词汇,缺乏在具体情境下的深度刻画。就像描述一场美丽的日落,可能只是简单地说“那日落美得让人陶醉”,却没有描绘出日落时天空色彩的渐变、霞光洒在身上的温暖感受,以及面对这一景象内心涌起的对自然之美的敬畏等细腻情感。

有文学研究机构对 AI 生成的文章与人类创作的文章进行了对比分析,从情感词汇的丰富度、情节逻辑的严谨性、观点独特性等多个维度进行评估,结果显示 AI 生成文章的情感词汇丰富度仅为人类创作文章的 40%,情节逻辑连贯性低 30%,观点独特性更是存在显著差异。文学评论家在学术研讨会上也多次指出,AI 缺乏真实生活体验与情感认知,难以创作出深刻且富有灵魂的文章。

AI 生成“车轱辘话”的成因

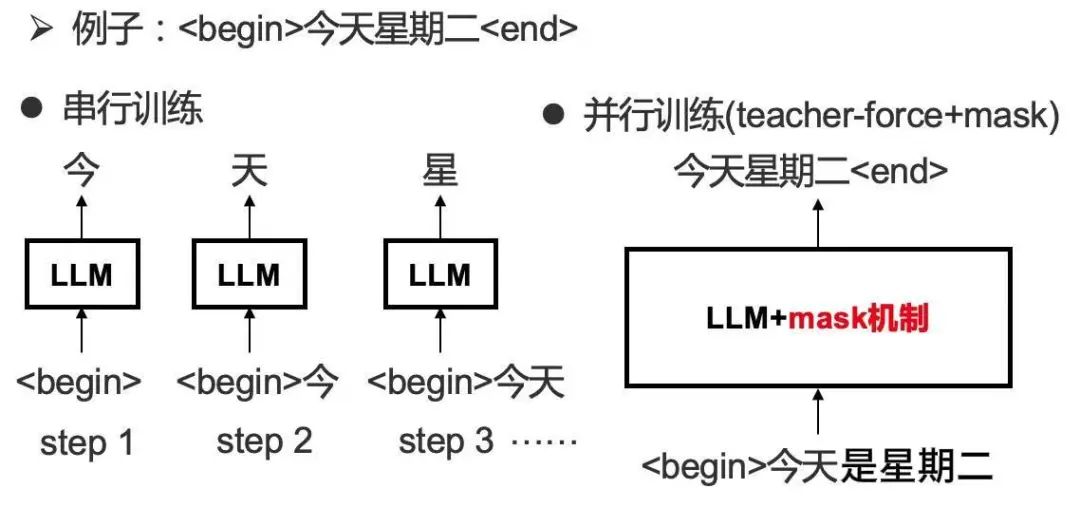

语言大模型写作的技术原理较为复杂,其核心在于基于 Transformer 架构的深度学习模型。首先,模型经过大规模的预训练,将海量文本数据转化为数字形式输入模型。模型中的神经元通过构建复杂的网络结构,学习文本中的词、句和篇章之间的关系。例如在处理“我喜欢草莓”这句话时,模型会分析“我”“喜欢”“草莓”这些词汇之间的语义关联及其在语法结构中的位置关系。在这一过程中,模型通过不断调整神经元之间的连接权重,优化对语言模式的理解,比如掌握不同词性词汇搭配的概率,例如“喜欢”后接名词的概率较高,而“草莓”作为常见的被喜欢对象,在模型学习的语料库中也有相应体现。

当接到“写一篇关于旅游的文章”的指令时,模型会将该指令转化为内部可理解的向量形式,从第一个词开始进行预测。

它会基于之前学习到的语言模式,计算下一个最可能出现的词的概率分布。假设模型已经输出了“旅游”,接下来预测下一个词时,它会参考训练数据中“旅游”后面常见词汇(比如“是”“可以”“能”等)的出现概率,选择概率较高的词进行输出,然后再以上一个词和新输出的词为基础,继续预测下一个词,逐步生成完整的句子和段落,直到完成文章。这个过程就像一个人在脑海中搜索词汇,依据以往积累的语言经验组织语句,但它并未真正理解旅游的实际体验和情感内涵,仅仅是依照数据中的概率模式拼凑内容。

大学生的“紧箍咒”:论文 AI 率的计算方式及其准确性

1. AI 率的计算逻辑:比对与概率判定

目前,许多高校常用的论文 AI 检测工具(如知网 AI 检测、Turnitin AI 检测等)原理与内容查重相似,但比对对象从“已发表文献”转变为“AI 生成内容的特征库”。

这些工具会分析论文的语言风格,例如句子长度的规律性、词汇的重复程度、逻辑转折的流畅性等,然后将这些特征与已知的 AI 生成文本特征进行比对,计算出文本中“符合 AI 生成规律”的部分占比,这就是所谓的“AI 率”。

2. 准确性争议:误判与“反检测”的博弈

然而,AI 率的准确性始终备受质疑。一方面,某些学生原创论文因语言风格过于规整(例如逻辑严谨、用词规范),可能被误判为“高 AI 率”;另一方面,网络上也流传着各种“降 AI 率技巧”(如故意打乱句式、替换生僻词),可能使 AI 生成的内容逃避检测。

此外,AI 技术本身在不断进步,新的生成模型可能会模仿人类的“瑕疵”,使得检测工具难以识别。因此,大多数高校会将 AI 率作为参考,而非唯一标准,最终还会结合导师的人工审核来判断论文的原创性。

我观察到最近 Loki 更新的 GPT- 5 测评,发现其中短文写得极接近真实人类的文笔,除了缺乏一些特定的写作风格和用语,几乎无法察觉出端倪。

技术对抗:有哪些工具可以识别 AI 生成的内容?

1. 文本检测工具:各有侧重,各有局限

- 知网 AI 检测:在高校中广泛使用,主要针对学术文本,能够识别主流的大模型(如 GPT、文心一言)生成的内容,但对小众模型的检测能力相对较弱。

- Originality.ai:一款商业化工具,支持多语言检测,准确性较高,但需要付费使用。

- GPTZero:一款免费的工具,专注于“识别 GPT 生成文本”,通过分析“困惑度”(文本的不可预测性)来判断是否为 AI 生成,适合初步筛查。

2. 图像检测工具:揭示细节中的“马脚”

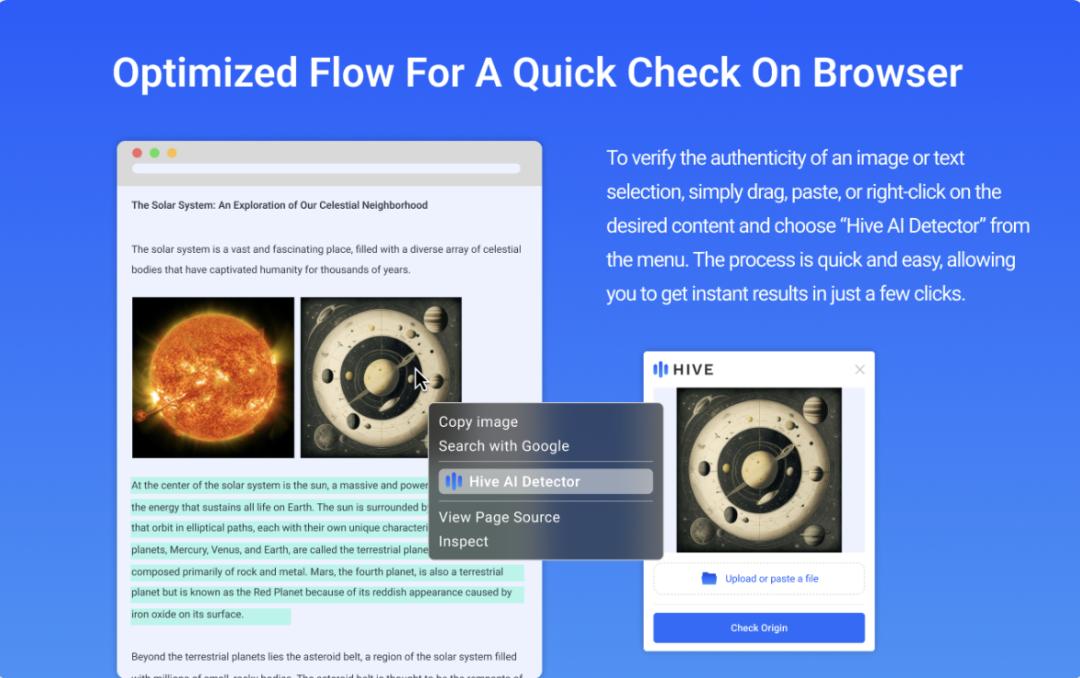

- HiveAI:能够分析图像的元数据(如是否带有 AI 生成的数字水印),同时检测像素分布的异常(如边缘模糊、细节矛盾)。

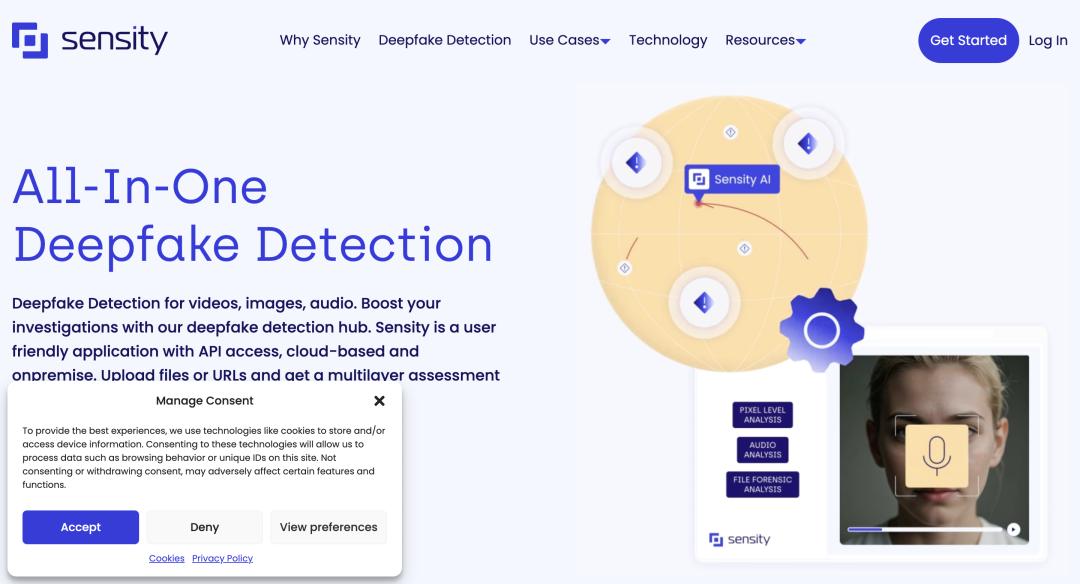

- Sensity:专注于深度伪造图像的识别,尤其擅长检测 AI 生成的人脸,能够发现瞳孔反光、皮肤纹理等细节中的不自然之处。

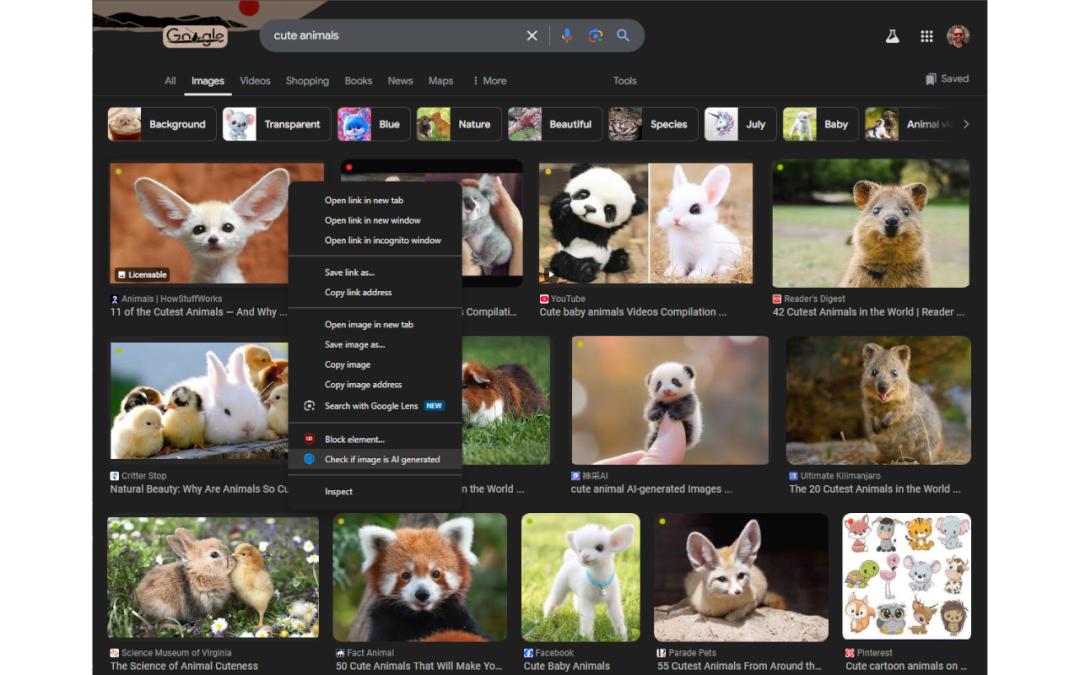

- 谷歌 AIImageDetector:一款免费的工具,通过分析图像的“噪声模式”(AI 生成图像的噪声分布与真实图像不同)进行判断,适合普通用户快速验证。

思考是内容的灵魂

“AI 味”的存在,本质上反映了 AI 技术尚不成熟的现实,大语言模型的推理方式本质上与人类存在差异,因为人类的大脑复杂而精密,表面上看似检测到的电信号,实际上可能是灵感的闪现;

而 AI 率的争议则体现了技术应用与教育公平之间的博弈。对论文创作者而言,AI 率的出现,实际上是利用一种形而上的技术,试图解决另一种形而上的问题,这其中蕴含着一种荒谬的意味。我们到底害怕的是无效的创作内容,还是对优秀创作者的辛勤耕耘与创作的渴望,教学体系中固有的问题又该如何解决,论文是否应成为检验毕业的标准?或许在未来的某个时间点,会有新的答案。

毕竟,真正有价值的内容,始终孕育着人类独有的思考。

本文由 @人工智能怨气指南 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自 Unsplash,基于 CC0 协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务