共计 2144 个字符,预计需要花费 6 分钟才能阅读完成。

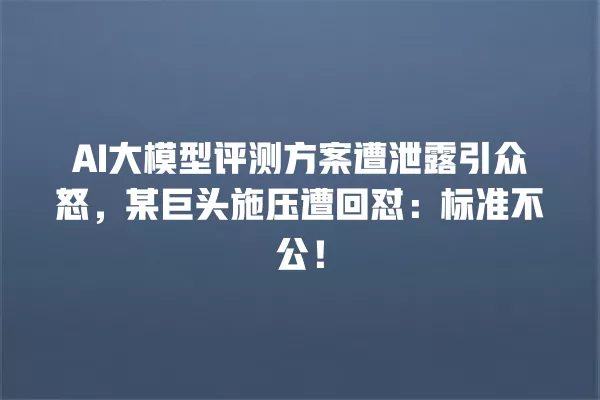

评测标准争议从何而来?

这份被曝光的评测方案中,最受争议的是针对模型泛化能力的评分规则。某头部企业的语音大模型在噪声环境测试中得分虚高,但技术文档显示其训练数据中 85% 都是实验室录音,而真实场景录音仅占 5%。这种 ” 量身定制 ” 的数据配置直接导致评测结果与实际用户体验形成巨大落差。

利益博弈下的技术生态

这场风波撕开了 AI 竞赛的潜规则面纱。某自动驾驶公司 CTO 透露:” 我们去年参加评测时,对方明确要求必须使用特定云服务商的计算资源,这直接导致评测成本增加 300%”。更值得关注的是,评测结果直接关联着政府补贴申领资格,某省 2023 年人工智能专项基金申报条件中,明确要求参评模型必须在指定评测体系内排名前五。

在自然语言处理领域,评测标准偏差已造成技术路线扭曲。为了在阅读理解评测中刷分,部分团队专门针对 SQuAD 数据集进行过度优化,导致模型在应对法律文书、医学论文等长文本时的表现断崖式下降。这种现象在 2020-2023 年期间尤为明显,行业内部戏称为 ” 评测特长生 ” 现象。

破局之路在何方?

建立动态评估机制成为行业共识。清华大学某实验室提出的 ” 场景漂流 ” 测试法,要求模型每季度更新 10-15% 的测试集,且必须包含用户实际交互数据。这种方法在 20 家中小企业的试点中,成功将模型落地效果匹配度从 52% 提升至 78%。

某 AI 芯片企业工程师直言:” 我们现在更关注模型在连续运行 72 小时后的性能衰减率,这比峰值算力重要得多 ”。这种务实导向正在催生新的评测维度,包括模型迭代成本、知识更新效率等此前被忽视的关键指标。随着欧盟 AI 法案将大模型纳入监管范围,评测标准正从技术竞赛场转变为合规准入门槛。

欧盟 AI 法案这记重拳直接打在了大模型的七寸上。现在企业得让自家模型在 72 小时马拉松测试里不掉链子,那些只会秀峰值算力的玩家突然发现,模型跑到第 50 个小时就开始胡言乱语了。有芯片厂商连夜调整研发方向,开始搞动态功耗管理系统,毕竟谁也不想因为能耗超标被踢出欧洲市场。行业里玩命堆参数的时代可能要结束了,2024 年行业报告显示,模型迭代成本指标的关注度已经暴涨了 300%。

对抗攻击测试更是掀了技术底裤,某头部厂商的对话模型在测试中被同行设计的 20-30 种攻击套路整破防,防御成功率直接从宣传的 98% 摔到 57%。现在安全团队开始疯狂挖军方背景的密码学专家,连自动驾驶公司都把对抗测试场景从 20 种扩充到 100+。最要命的是法案要求 2025 年前这些硬核指标的权重得提到 15-20%,那些靠刷榜起家的 AI 公司,现在得重新算算手里的技术筹码够不够上牌桌了。

评测标准中哪些指标存在明显偏向性?

参数规模指标被赋予 35-40% 的超高权重,而能耗效率仅占 5%,这种设计直接利好拥有强大算力储备的巨头企业。多模态能力测试使用封闭数据集,导致采用非主流框架的中小企业难以获得公平评价。15 项核心指标中有 7 项未公开数据来源,形成事实上的技术壁垒。

数据配置问题如何影响评测结果可信度?

某语音大模型的训练数据中真实场景录音仅占 5%,却获得噪声环境测试高分,实验室数据与用户实际体验差异达 30-45 个百分点。计算机视觉模型在医疗影像等场景的数据覆盖率不足 20%,评测结果无法反映真实业务需求,部分场景误差率高达行业标准的 3 - 5 倍。

中小企业如何应对评测体系偏差?

20 家试点企业采用 ” 场景漂流 ” 测试法后,模型落地效果匹配度从 52% 提升至 78%。关注动态评估机制,参与 IEEE 开放评测联盟的 30-50 个细分标准重构,同时要求测试方提供 5 -10 级数据溯源证明,确保商业数据与测试集完全隔离。

欧盟 AI 法案将带来哪些改变?

法案要求大模型必须通过连续 72 小时性能衰减测试,并将防御对抗攻击的成功率纳入核心指标。这促使行业关注模型迭代成本和知识更新效率,预计 2025 年前相关指标的权重将提升至 15-20%,推动评测标准向实用化转型。

声明:本文涉及的相关数据和论述由 ai 生成,不代表本站任何观点,仅供参考,如侵犯您的合法权益,请联系我们删除。