共计 3750 个字符,预计需要花费 10 分钟才能阅读完成。

6 月 19 日,字节跳动的研发负责人洪定坤宣布了与 TRAE 合作的首个开源项目。根据公开的信息,该项目包含 TRAE 的两个基本功能:「代码补全」和「局部代码生成」。这两个功能能够根据编程时的上下文自动推测和补全代码,从而显著提高编程的效率。

此外,TRAE 还实现了「自然语言编程」的功能,这并不仅仅是「产品经理描述需求后,让 AI 进行开发」。在开发「积流成江」这个应用时,依然遵循传统的工程师开发流程,更多关注编码逻辑和技术方案。一个 300 行的功能模块,可能只需 200 字的方案描述。

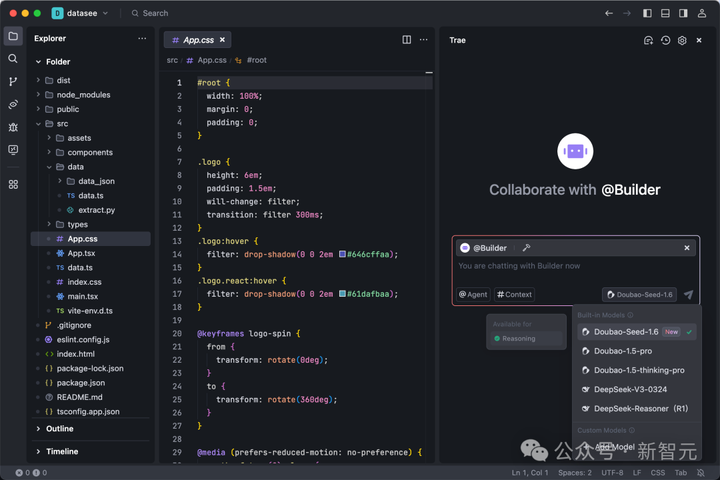

值得一提的是,底层模型的强大能力也是项目顺利完成的关键之一。此次开发中使用的 doubao-dev 模型,正是基于字节跳动新发布的豆包 1.6 系列。TRAE 团队在此基础上,针对工程开发场景进行了进一步的训练。

根据字节跳动的说法,TRAE 的用户在最近几天应该已经获得了豆包 1.6 的最新版本,相信这将进一步提升开发效率。

有体验过的朋友能否分享一下你的看法?你如何评价当前 AI 开发的水平?

创造一款 AI 编程工具,并通过该工具进行 AI 编程的体验究竟如何?未来的 AI 开发模式会是什么样,开发者和 AI 的结合能迸发出多大的创意?也许字节跳动的研发负责人洪定坤能够为你解答。

最近,他开源了自己利用 AI 编程完成的第一个项目——一款英语学习应用「积流成江」(Streams to River)。

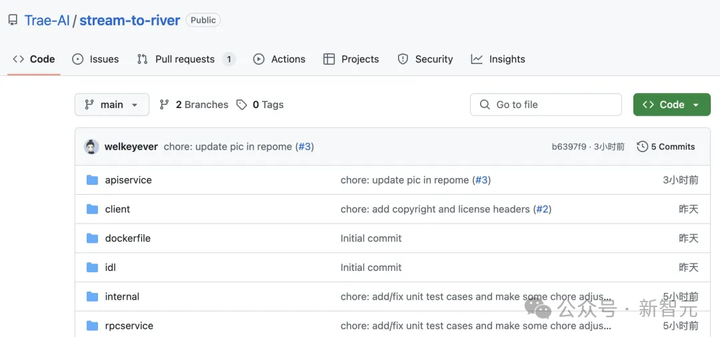

GitHub 链接:https://github.com/Trae-AI/stream-to-river

更令人惊讶的是,洪定坤表示,这次开发的 85% 代码是通过自然语言对话生成的,尽管他在这三天内还被繁忙的公务所困。

他所使用的工具正是字节跳动开发的 TRAE,这是一款 AI 原生 IDE,名称源自“The Real AI Engineer”的缩写。

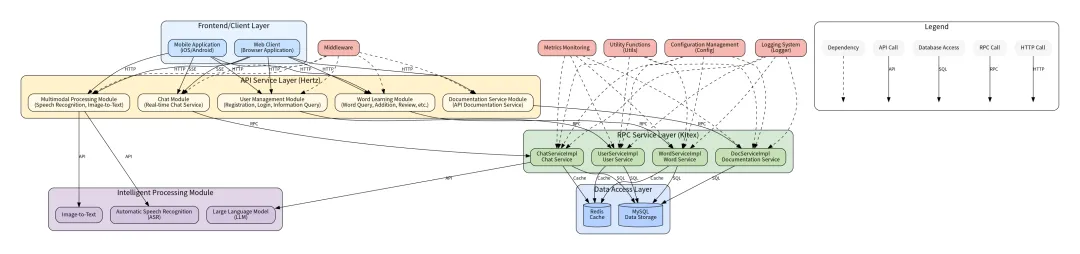

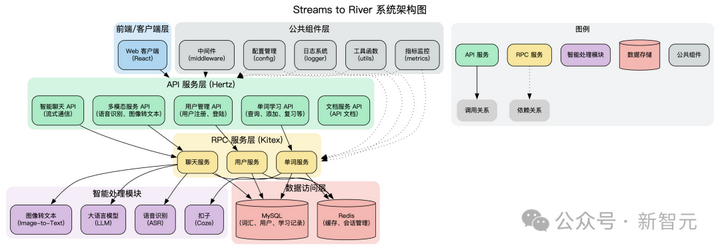

从技术角度来看,「积流成江」是基于 Hertz 和 Kitex 框架构建的微服务系统,专注于词汇学习和语言处理。

它提供了包括用户认证、单词管理、复习进度跟踪、实时聊天、语音识别和图像转文本等功能模块的完整解决方案。

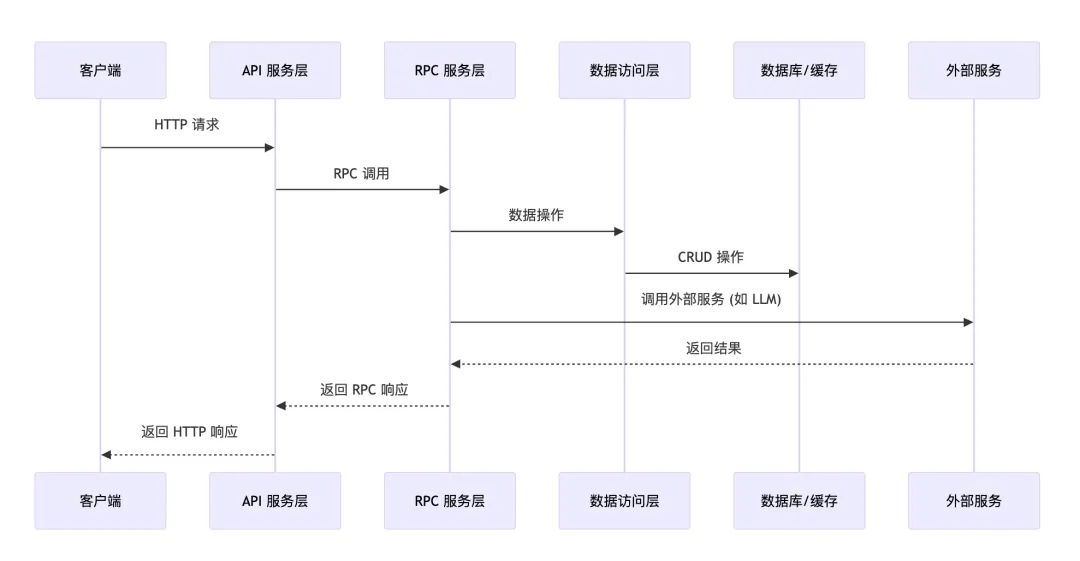

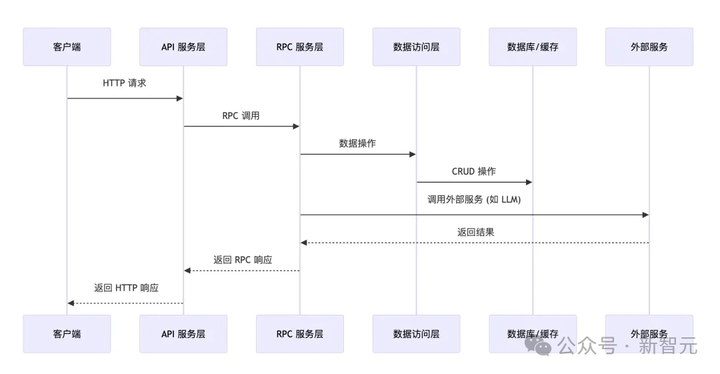

该系统采用前后端分离的架构,主要分为 API 服务层、RPC 服务层、数据访问层和智能处理层。

系统架构图

组件调用关系图

技术高管与 AI 合作编写的代码到底达到了什么样的水平?感兴趣的读者可以直接前往 GitHub 查看相关内容。

三天内「写」出一个上线产品

过去,开发一个类似于「积流成江」的应用,通常需要几周甚至一个月的时间。

然而,洪定坤通过亲身实践证明,现今的 AI 编程可以通过「自然语言」迅速完成项目。

想象一下,一场重要的发布会(火山引擎 Force 原动力大会)即将举行,而在几天内,作为技术副总裁的洪定坤需要向大家展示公司在 AI 编程领域的核心产品——TRAE。

他可以准备一份精美的 PPT,详细列出各种数据和功能,向大家展示这个工具的强大之处。

但他认为,这样的方式还不够。

于是他心想:「如何才能让大家 真正体验到 AI 编程的魅力呢?」

「或许,作为一名开发者和用户,分享自己使用 TRAE 的过程,会更生动、真实。」

真实的体验才是最重要的。

洪定坤提到,他在工作中有学习英语的需求,但传统的单词学习软件存在两个问题:

1. 学习的单词与实际工作中使用的单词脱节。

2. 工作中需要的单词缺乏合适的练习场景。

那么,如何解决这些问题呢?

正好,当前的大型模型,例如字节的豆包,可以很好地与我们进行对话。

因此,将这两种功能结合在一起的想法便应运而生。

于是,「积流成江」就诞生了。

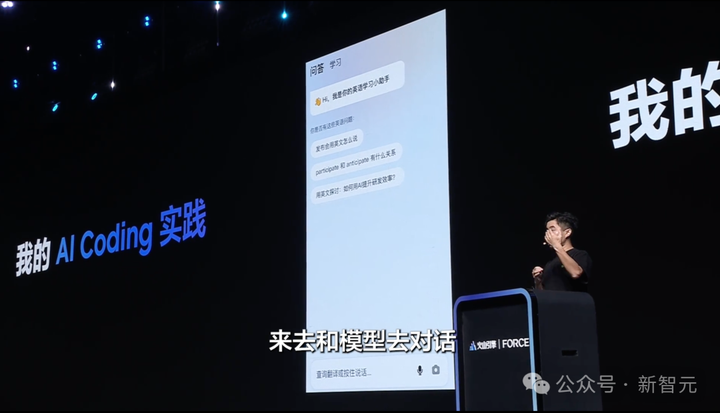

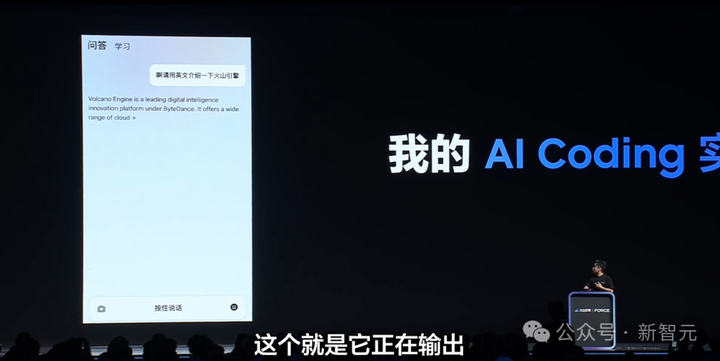

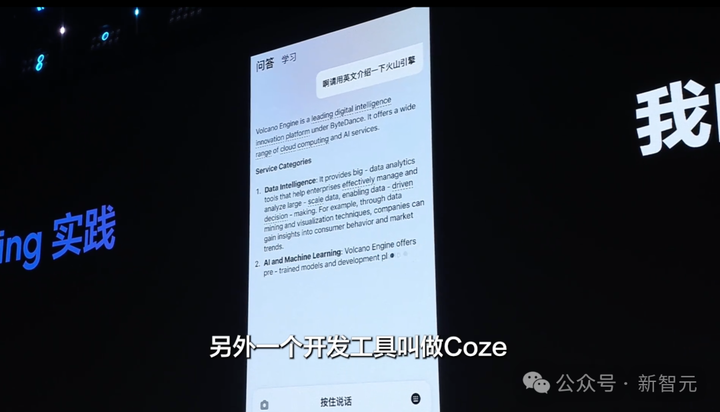

在大会上,洪定坤现场演示了如何通过「语音」指令让「积流成江」生成一段关于火山引擎的介绍文本。

生成的文本中,还会自动对特定的需要学习的英文单词进行下划线标记。

值得注意的是,此功能依赖于字节的另一款产品 Coze 智能体实现。

洪定坤表示,他已经很久没有在一线编码,「有些生疏」,但在 TRAE 的帮助下,他仅用三天时间便开发出了这样一个高完成度的英语学习应用。

在整个过程中,最关键的是,洪定坤主要通过编程逻辑的 「自然语言」 来实现以前的工程化开发流程。

用他的话说:

一个 300 行代码的功能,或许只需 200 字的方案描述。

这个产品不仅仅是一个简单的演示,它已经上线,体验地址为:https://sstr.trae.com.cn

我们在全流程的体验中发现,难以相信这是在短短三天内完成的产品,其完成度几乎达到 100%:

- 融入了聊天界面,可以主动确定和制定学习内容。

- 能够自动定位对话中的英文单词。

- 点击英文单词可切换到学习模式。

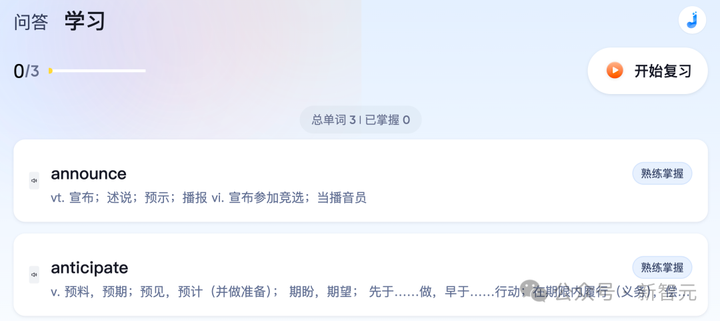

- 轻松将单词收录在学习集中。

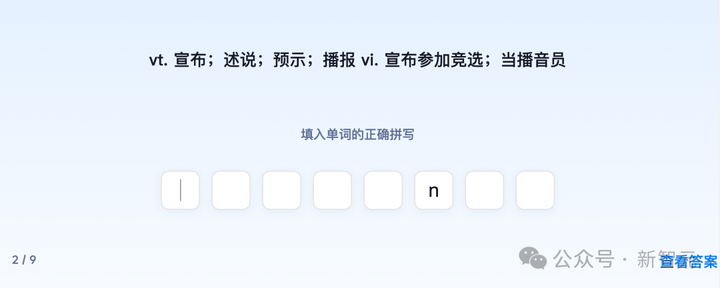

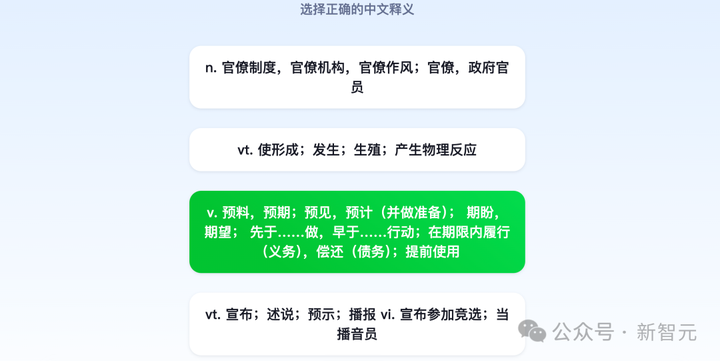

- 提供复习功能,涵盖发音、释义、拼写等多方面的学习支持。

积流成江如何帮助你记单词?

这款应用的复杂性有多高,为什么洪定坤在 Force 大会上特别强调介绍?

其实,主要是通过这款产品的复杂程度来展示AI 编程的进化程度。

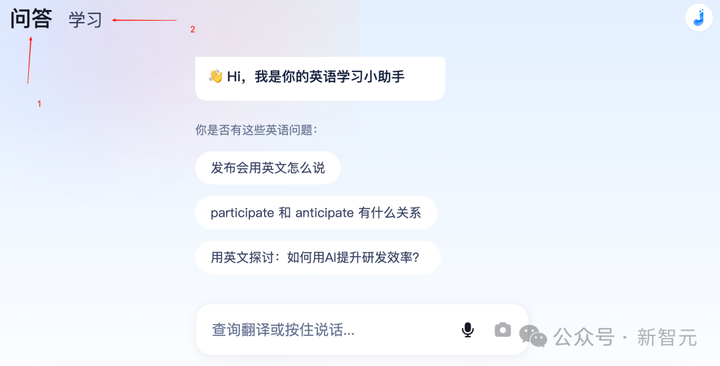

「积流成江」设有两个页面选项卡。

第一个选项卡集成了豆包的大模型能力,用户可以通过文字和语音与模型互动。

生成特定的学习文本。

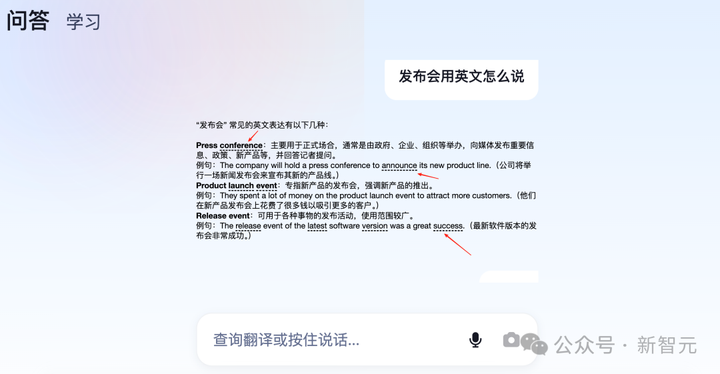

在文本生成后,「积流成江」会对特定单词进行下划线标注,点击后可打开单词卡片。

探索 AI 编程新纪元:字节的 TRAE 如何改变开发方式

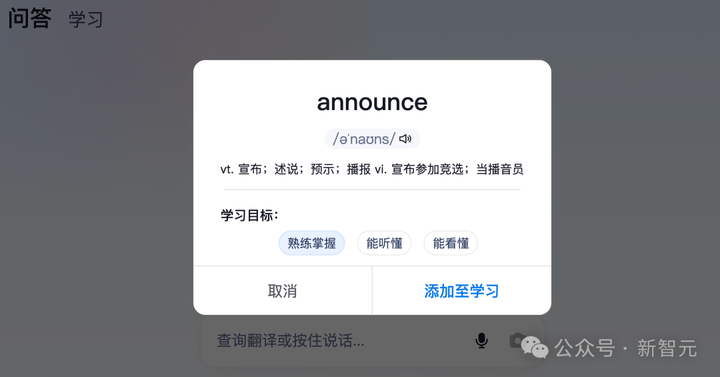

在单词卡的设计中,学习目标已经设定好,用户可以轻松通过点击「添加」按钮将内容纳入学习选项卡。

一旦选择开始复习,学习界面就会呈现出多种功能,帮助用户巩固单词记忆,例如单词的补全和对应中文释义的选择。

在使用「积流成江」时,最令人愉悦的一点是,通过引入大模型的能力,学习英语的过程得以高度个性化,用户可以根据自己的兴趣选择学习文本,从而显著提升学习的积极性。

例如,若我希望了解显卡的知识,便可以请求「积流成江」生成相关的英语内容,看到满屏的 RTX 4090,确实极大地激发了我的学习热情。

同样,用户也能围绕工作需求定制生成相应的文本。

字节为何坚定投入 AI 编程领域?

今年,AI 编程热潮催生了国外 Cursor、Copilot 和 Windsurf 等众多创新产品,那么国内是否也有相应的竞争产品呢?

答案是肯定的!那就是 字节在年初推出的 TRAE。

作为一家重视技术研发的企业,字节的研发效率直接影响着公司的整体运行效率。

洪定坤提到,他们在 AI 编程方面的探索已有一段时间,自从 GPT-3.5 问世,他们就意识到这可能是大模型的一个极具潜力的应用领域。

因此,TRAE 的名称寓意为「真正的 AI 工程师」,象征着 AI 大模型将带来编程领域的重大变革。

起初,尽管大模型的能力尚不足以胜任复杂的编程任务,但在过去不到一年的时间里,其进化速度超出了所有人的想象。

如 GPT-4.1、Gemini 2.5 Pro、Claude Opus 和 DeepSeek-R1-0528 等底层模型在编码能力上都取得了显著的突破。

此外,字节在火山引擎 Force 原动力大会上发布的豆包大模型 1.6 在编程能力上也取得了重要进展。

这些进展让 AI 编程的实际应用成为可能,并有望引发编程领域的一场范式革命——就如洪定坤所述,利用自然语言实现真实的可用工程项目。

首先,TRAE 具备两个核心功能:「代码补全」和「局部代码生成」,能够在编写代码的过程中,基于上下文智能推测并补全代码,从而提升编程效率。

其次,TRAE 所实现的「自然语言编程」,并非仅仅是「产品经理描述需求,然后让 AI 来开发」的简单模式。

「积流成江」的开发过程依然遵循工程师主导的模式,除了功能外,更加关注编码逻辑和技术方案本身。

更值得一提的是,底层模型能力的提升,使得 TRAE 的开发效率得到了质的飞跃。

洪定坤表示,他们推动 TRAE 发展的初衷有几个重要愿景:

· 技术普及,让每个人都能成为开发者

每一次技术革命都是一次筛选。在上一次互联网数字革命中,编程语言作为计算机历史上的伟大发明,以简洁优雅的语法和语义规则,明确指令,驱动计算机完成各种任务。

无论技术如何演进,字节始终相信,代码是未来最重要的、也是唯一的工具,能够让计算机执行复杂任务。

代码是数字世界的基础生产力工具,而 AI 的出现前所未有地 降低了大众掌握代码的门槛。

· 提升研发效率

认真打磨开发工具对于公司和个人开发者都极具意义,能够显著提升工作效率。

如今,在字节跳动内部,超过 80% 的工程师正在使用 TRAE 等产品来辅助开发。

同时,也有 相当比例的代码是通过 AI 生成的。

· 追求智能的极限

最后,字节在大模型领域的工作,其重要使命之一就是 追求智能的上限。

编程作为高度结构化且逻辑严谨的任务,对模型理解复杂语义结构、逻辑推理、算法设计和精确表达要求极高,这将有效推动模型智能水平的提升。

因此,帮助更多人掌握代码以完成更复杂的任务、提高专业工程师的工作效率,并助力模型追求更高的智能上限,是洪定坤和他的团队全力以赴做 AI 编程的原因。

洪定坤通过「积流成江」向我们展示了真正的 AI 原生开发新范式。

在 TRAE 的助力下,或许每个人都有机会成为「真正的 AI 工程师」。

AI 编程的未来,或许已经悄然降临。

看到洪定坤的亲身实践,真令人印象深刻,AI的潜力似乎比我们想象的还要大!