共计 9804 个字符,预计需要花费 25 分钟才能阅读完成。

(用户的损失最大?

我们不能简单地将损失归结到某一方,实际上,Claude 正从容地布局更为深远的战略。

最初,Cursor 的功能仅仅是作为连接工具,而如今 Cursor2.0 则已经具备了独立的编程模型。

然而,这种进步仍然无法解决急迫的需求,因为在编程 AI 领域,真正的强者依然是 GPT 与 Claude。

虽然 TRAE 的表现不及 Cursor,但借助 Claude 和 GPT 的力量,它也能够分得一杯羹。

这一切都发生在 Claude Code 和 GPT5-Codex 尚未问世的年代。

而随着 Claude Code 和 GPT5-Codex 的推出,AI 编程的局面发生了翻天覆地的变化,原生的强大模型开始取代那些依赖外部工具的编程方案。

目前 GPT 由于资金问题,仍未停止服务,只要它能够维持自己的领导地位并获取更多利润,GPT 和 Gemini 也会考虑暂停供应。

不仅 Claude 在积极进取,GPT 同样渴望独占鳌头。

Claude 摆脱了地域限制,最大的优势在于它已经具备了独立的实力,不再依赖其他编程产品来进行推广。

它可以完全自给自足。

在 AI 编程中,最大的挑战就是高昂的 Tokens 成本。

任何 AI 编程都无法逃避这个高成本的限制。

从 Claude 的角度来看,Claude 在 11 月份取得了显著进展,现在的 Claude Code 实现了将 150K Tokens 的任务压缩到仅需 2K Tokens 完成。

这意味着成本下降了 98%!!!

几天前我看到 Anthropic 发布的新技术指南,老实说,我第一次看完就愣住了。

从 150,000 个 tokens 直接降到 2,000,这并非简单的优化,而是一次颠覆性的变革!

这一次的降价幅度甚至超过了 Deepseek 的 3.2……

既然自己能够做到,为何还要为他人做嫁衣呢?

我毫不夸张地说,这可能是我在 2025 年所见过的最卓越的 AI Agent 优化方案。

老实告诉你们,我之前参与的多个工具 Agent 项目,API 账单让我心惊胆战——一个月竟然高达 $360,000,这真让人无法承受。

现在,Anthropic 直接将成本降低到 $4,800,节省了 98.7%。

而且,响应时间也从 20 秒缩短至 5.5 秒。

传统方法将 AI 模型视为数据中转站,所有中间数据都需经过一遍上下文,这样的做法岂不是自找麻烦?

这次,Anthropic 将数据处理直接放入执行环境,模型仅需负责生成代码和接收结果,决策层与执行层被彻底分开。

我总结了三个最为重要的亮点:

- 环境内处理 – 中间数据完全不进入模型,Tokens 节省超过 99%+

- MCP 代码 API 化 – Agent 变成了编码者,所需工具可以自行导入

- 真实的金钱节省 – 不再是空谈,生产环境每月节省 $355,200

在多工具 Agent 的实现中,大家都明白,面临的问题根本不是优化可以解决的,而是 架构性问题。

如果想要功能全面,就得接入大量工具;若想节省 Tokens,功能就只能削减。

这不是两难选择,而是一个死循环。

说实话,企业级 Agent 没有 50-200 个工具根本无法运转。

如数据库查询、发送邮件、与 Salesforce 对接、Slack 协作、GitHub 集成,这些都是基本配置。

我之前的项目,仅工具接入就花费了整整两个月。

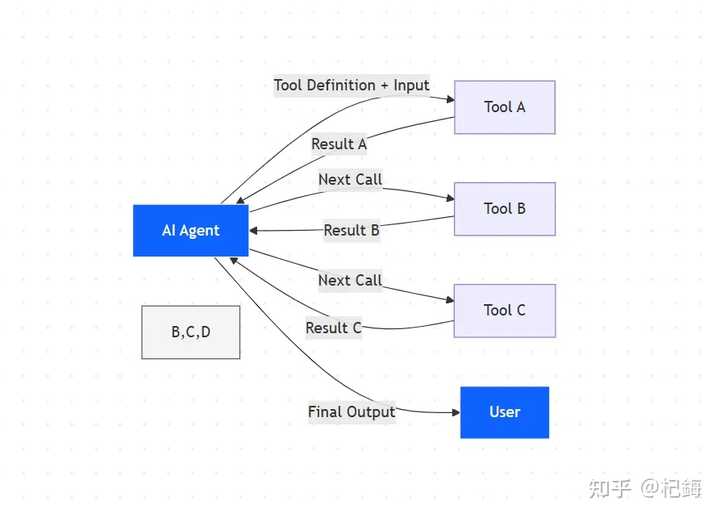

更麻烦的是调用频率。

一个复杂的工作流往往需要 10-30 次工具调用,链式依赖 令人苦恼——工具 A 的输出需传递给工具 B,B 的输出再传给 C,每次都得在上下文中转一圈。

传统架构无法进行并行处理,只能顺序执行,眼睁睁看着延迟不断增加。

调用次数与成本的关系如下:

| 任务复杂度 | 调用次数 | 数据量 | Token 消耗 |

|---|---|---|---|

| 简单任务 | 3- 5 次 | <1KB | 2K-5K |

| 中等任务 | 10-15 次 | 10-50KB | 20K-50K |

| 复杂任务 | 20-50 次 | 100-500KB | 100K-500K |

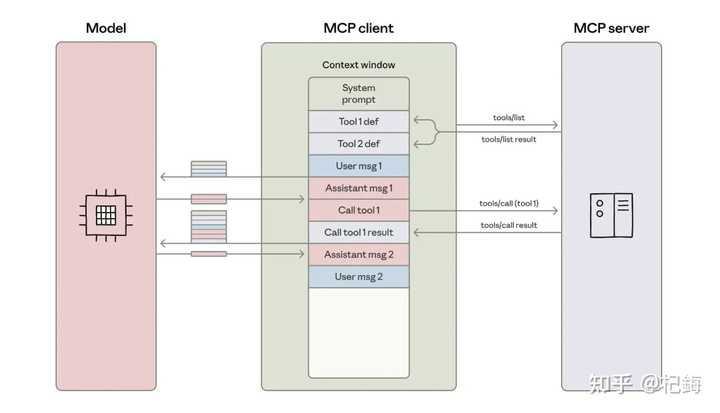

MCP (Model Context Protocol)协议的诞生确实是个喜讯,统一了工具接入的标准。

过去每个服务都需独立开发 SDK、完成认证和数据格式,而现在通过 JSON Schema 定义工具签名,并利用 list_tools() API 自动发现工具,省去了很多麻烦。

但是!

尽管 MCP 解决了接口碎片化的问题,理论上想接入多少工具都可以,实际上仍然会被上下文窗口限制。

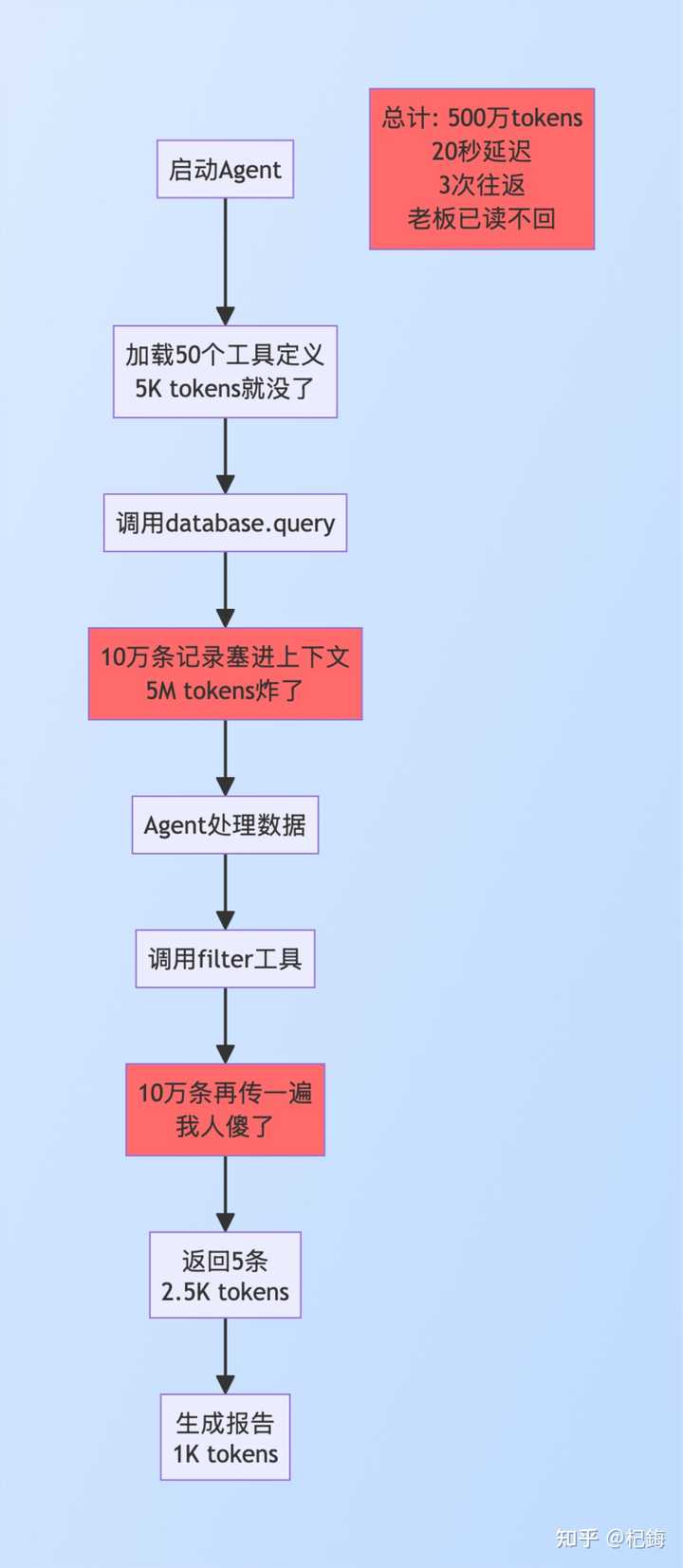

例如,假设一个项目需要从 10 万条记录中筛选 5 条生成报告。

传统流程的巨大缺陷:

阶段 1 – 工具定义预加载:

- 将 50 个工具定义全部放入上下文

- 还未开始工作,5,000 tokens 就消耗殆尽

- 那时我就觉得不对劲

阶段 2 – 数据检索(此阶段的消耗极大):

- Agent 调用 database.query()

- 100,000 条记录 → 全部进入上下文

- Token 消耗:100,000 条 × 50 tokens = 5,000,000 tokens

- 延迟:序列化、传输、解析,至少 15 秒

- 问题在于:10 万条中 99,995 条都是无用数据,全部都进入了上下文

阶段 3 – 数据过滤:

- 调用 filter()工具

- 10 万条数据再传一次(没错,又要传一次)

- 最终返回 5 条结果

阶段 4 – 生成报告:

- 最后只需传递 5 条了

- 但前面的过程已经消耗巨大

总账单:

- Token:5,006,000(约 500 万)

- 往返:3 次

- 延迟:20 秒

- 最令人啼笑皆非的是:10 万条数据走了一圈,真正有用的只有 5 条

流程如下:

这说明了什么呢?

传统架构将 AI 模型视为数据总线,所有数据都必须经过模型这一关。

模型不仅负责决策,还要承担搬运数据的重任,Token 消耗与数据量成正比,这样能不出问题吗?

工具定义预加载是首个大坑。Agent 一启动就必须将所有工具定义放入上下文:功能描述、参数说明(类型、必填项、默认值、验证规则)、返回格式、2- 3 个使用示例。

50 个工具的基础开销为:50 × 100 tokens = 5,000 tokens。然而,规模效应却是最令人头痛的:

如果有 200 个工具,Token 消耗直接起步就是 20,000 tokens。

更可笑的是工具的利用率。

统计显示,单次任务平均仅使用 3 - 5 个工具,利用率仅为 2.5%。

这意味着 97.5% 的工具定义 Tokens 纯属浪费。

为何不能按需加载?

因为传统架构要求预先声明所有工具,模型必须“看到”所有选项才能选择。

中间结果传递的重复传输问题。

Salesforce 的真实案例:

每次往返 500 毫秒,三次加起来光是在网络上就耗费了 1.5 秒。

数据序列化还有隐性成本。

原始 1KB 数据转为 JSON 时,体积会膨胀至 1.5-2KB,膨胀系数为 1.5- 2 倍。

模型还需要时间理解 JSON 结构。

Anthropic 的解决思路可以概括为一句话:不再优化,而是直接更换架构。Agent 不再是工具的使用者,而是代码的编写者。MCP 服务器不再是函数调用接口,而是代码模块。

核心理念听起来简单,但实施起来却非常复杂:模型不再执行工具,而是生成执行工具的代码。

代码在独立环境中运行,数据处理全部在环境内完成,模型只需接收最终结果。

MCP 服务器重构为代码 API,从函数调用转变为模块导入(这个转变至关重要)。

// 传统方式(每次调用都是灾难)agent.call_tool("search", {query: "..."})

// 代码执行方式(简洁清爽)import {search} from 'mcp-server'技术实现(支持 TypeScript 和 Python 双语)!

TypeScript 版本:

// mcp-servers/salesforce/index.ts

export class SalesforceClient {async search(params: SearchParams): Promise {

// 这里的实现全在执行环境,模型根本不知道

const results = await this.api.query(params);

return results;

}

async update(id: string, data: object): Promise {

// 所有操作都在环境内,秒啊

return await this.api.update(id, data);

}

}Python 版本:

提升开发效率的利器:从工具到安全架构的全面优化

类型提示的引入极大地改善了开发体验,IDE 的自动补全、类型检查和文档悬停功能让编程变得更加高效。通过对 async/await 的原生支持,并发性能也显著提升。

懒加载机制的按需加载,这一设计让 Token 的使用效率大幅提高!

传统方法下,预加载 50 个工具需要 5K tokens,而在新方法中,只需导入 2 个工具,则消耗0 tokens。

为何是 0?

因为导入语句不会占用模型的上下文!

动态导入的实现方式如下:

// 运行时按需导入,想用啥导啥

const toolName = determineRequiredTool(task);

const module = await import(`mcp-servers/${toolName}`);

const tool = new module.Client();search_tools 工具发现 API,这个设计真是高明。

async function search_tools(query: string): Promise {

// 轻量级元数据,每个工具

tool.tags.includes(query) ||

tool.description.includes(query)

);

// 按相关性和流行度排序

return matches.sort(byRelevance).map(t => ({

name: t.name,

summary: t.summary

}));

}元数据索引在启动时构建,后续查询响应时间小于10ms。结合倒排索引与内存缓存,性能达到了极致。

在实际应用中:

- Agent 需要 ” 发送邮件 ”

- 调用

search_tools("email"),返回 3 个邮件工具(消耗 150 tokens) - Agent 选择 ”Gmail Sender”

import {GmailSender} from 'mcp-servers/gmail'- 仅加载这个工具,其余 197 个工具不受影响

工具选择的逻辑基于描述匹配度、历史使用频率和上下文相关性。

在此过程中,Agent 的角色发生了转变,从 ” 执行者 ” 变成了 ” 编排者 ”。它生成代码,但并不直接执行工具的调用,这就要求代码的质量必须得到保障:

- 使用 ESLint 和 Pylint 进行自动语法检查

- 通过 TypeScript 和 Python 的类型系统进行类型校验

- 复用最佳实践的代码模板库

模板库的使用可以有效减少生成错误,例如,标准化的数据库查询模板和 API 调用重试模板,都是经过验证的解决方案。

始终在环境内处理数据:确保数据不流出环境。

执行环境的安全隔离至关重要!

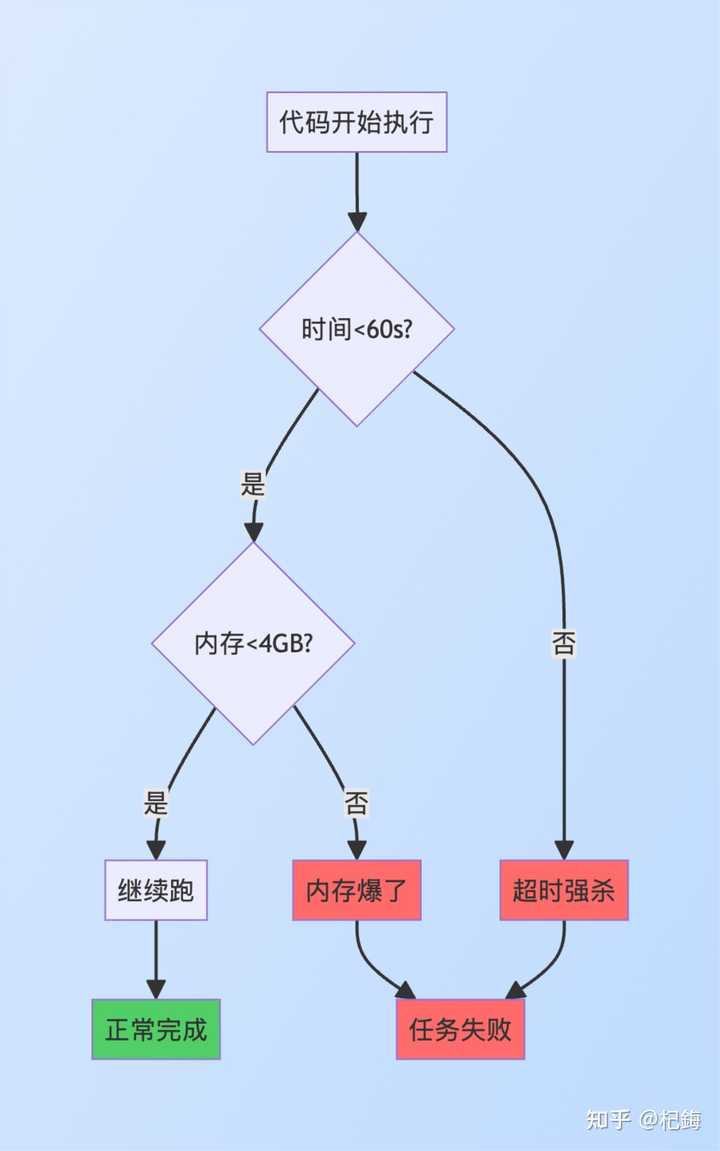

安全是首要任务,架构设计为:沙箱 + 资源限制 + 实时监控。

沙箱技术(结合 Docker 与 seccomp 的多层防护)

- 网络隔离:仅能访问 MCP 服务器,其他外部连接一律禁止

- 文件系统隔离 :代码库为只读,只有

/tmp可写,以防止破坏 - 进程隔离:独立容器,进程之间完全隔离

资源配额 是固定的规则:

- CPU:2 核

- 内存:4GB

- 执行

当超时发生时,会用 SIGALRM 信号强制终止。同时,内存溢出有 cgroup 限制,OOM killer 保护宿主机。

核心技术在于数据流的重定向!

Salesforce 案例的改写版(对比效果显著)

数据流向示意图:

数据库 → 执行环境内存(1000 条,模型不可见)

↓ filter 操作

执行环境内存(50 条,模型不可见)

↓ 计算聚合

执行环境内存(summary 对象)

↓ return

模型上下文(仅 summary,~100 tokens)执行时间统计:

- 数据库查询:2 秒

- 环境内过滤:0.05 秒

- 环境内聚合:0.05 秒

- 总计:2.1 秒

Token 的节省令人惊讶:1000 条数据中,有条目从未被序列化,50 条从未被传输,最终只有 summary 返回。节省率从 51K 降到 100,达到了 99.8% 的节省。

对于中间数据的内存管理,100K 条记录保留在环境内存中,而模型则对此毫无感知。选择合适的数据结构至关重要:JavaScript 数组和 Python 列表的原生性能最佳。

对于超大数据集,我们采用 Generator 逐条处理,避免全量加载:

function* processLargeDataset(data) {for (let item of data) {yield transformItem(item); // 逐条处理,省内存

}

}实时内存监控:

const memUsage = process.memoryUsage();

if (memUsage.heapUsed > threshold) {// 内存快爆了,切换流式处理}将 50 次调用合并为 1 次(这一优化简直太出色)

// 传统:50 次工具调用 = 50 次往返 = 25 秒等死

// 代码执行:一个循环搞定

const results = [];

for (let i = 0; i < 50; i++) {const result = await processItem(items[i]);

results.push(result);

}

// 总进一步的并发版本:

// 50 个并发请求,0.5 秒搞定

const results = await Promise.all(items.map(item => processItem(item))

);通过并发控制防止对服务器的过度负载:

import pLimit from 'p-limit';

const limit = pLimit(10); // 最多 10 并发

const results = await Promise.all(items.map(item => limit(() => processItem(item)))

);错误重试机制增强了容错能力:

async function retry(fn, times = 3) {for (let i = 0; i < times; i++) {

try {return await fn();

} catch (e) {if (i === times-1) throw e;

await sleep(1000 * (i + 1)); // 指数退避,别立即重试

}

}

}效果对比:真实的数据证明:

Token 节省率的计算方式:

延迟的改善:

Claude 的这一系列举措,优势明显!

一切都掌握在自己手中,不再依赖他人的帮助……

1. Token 效率:成本直降

不同规模的实际成本对比,这个数据表让多少老板感到心痛!

实施成本如下:

中规模项目的回本时间为:$50K ÷ $355K = 0.14 月,约为3.6 天。

3 年期总拥有成本(TCO)对比(传统方式与代码执行):

传统方式:$360K × 36 = $12.96M

代码执行:$50K + ($4.8K + $5K) × 36 = $402.8K

在 3 年内节省:$12.96M – $403K = $12.56M(节省达 96.9%)

2. 渐进式工具发现:告别预加载

search_tools 的完整实现,这个 API 设计堪称精妙!

// 元数据索引结构

interface ToolMetadata {

name: string; // 工具名

category: string; // 分类

tags: string[]; // 标签

description: string; // 描述

summary: string; // 摘要 <50 tokens

popularity: number; // 使用频率

}

// search_tools 实现

async function search_tools(query: string): Promise {

// 1. 加载轻量级索引

const allTools: ToolMetadata[] = await loadToolMetadata();

// 200 工具 × 50 tokens = 10K tokens(只加载一次)// 2. 关键词匹配

const keywordMatches = allTools.filter(tool =>

tool.tags.some(tag => tag.includes(query.toLowerCase())) ||

tool.description.toLowerCase().includes(query.toLowerCase())

);

// 3. TF-IDF 相关性

const scored = keywordMatches.map(tool => ({

tool,

score: calculateRelevance(tool, query)

}));

// 4. 排序:相关性 70% + 流行度 30%

const sorted = scored.sort((a, b) =>

(a.score * 0.7 + a.tool.popularity * 0.3) -

(b.score * 0.7 + b.tool.popularity * 0.3)

);

// 5. 返回 TOP10

return sorted.slice(0, 10).map(s => s.tool);

}

// 相关性计算

function calculateRelevance(tool: ToolMetadata, query: string): number {const words = query.toLowerCase().split(' ');

let score = 0;

for (const word of words) {if (tool.name.toLowerCase().includes(word)) score += 10; // 名字匹配权重最高

if (tool.summary.toLowerCase().includes(word)) score += 5;

if (tool.tags.some(t => t.includes(word))) score += 3;

}

return score;

}启动时构建倒排索引,查询响应时间小于10ms:

// 启动构建倒排索引

const invertedIndex = new Map<string, Set>();

for (const tool of allTools) {const words = [...tool.tags, ...tool.description.split(' ')];

for (const word of words) {if (!invertedIndex.has(word)) {invertedIndex.set(word, new Set());

}

invertedIndex.get(word).add(tool.name);

}

}

// 查询 O(1)复杂度,贼快

function fastSearch(query: string): string[] {const words = query.split(' ');

let results = invertedIndex.get(words[0]) || new Set();

for (let i = 1; i wordResults.has(x)));

}

return Array.from(results);

}Token 的对比(节省幅度惊人):

- 传统方式:预加载 200 个工具 = 20K tokens

- search_tools:返回 3 个匹配 = 150 tokens

- 动态导入:import 语句 = 0 tokens

- 总节省:99.25%

3. 大数据处理:不再惧怕数据量

性能曲线的对比显示,数据量越大,优势越明显!

性能的拐点出现在100 行。

对于少于 50 行的代码,传统方式更为简单,而超过 100 行时,代码执行的优势明显。

动态策略的选择:

数据管道的构建:

// 链式操作,内存峰值低

const pipeline = data

.filter(cleanData) // 清洗

.map(transformFormat) // 转换

.reduce(aggregateByGroup) // 聚合

.map(calculateMetrics); // 计算

// 流式处理超大数据

async function* streamProcess(dataSource) {for await (const batch of dataSource.batches(1000)) {

const processed = batch

.filter(validate)

.map(transform);

yield processed; // 逐批处理,内存可控

}

}处理 100K 行数据时,内存峰值仅需500MB,而不是全量加载时的5GB。

此外,还有编程控制流的优化,循环、条件和错误处理均为原生支持,50 次调用合并为 1 次执行,延迟降低了 25 倍;隐私安全方面,敏感数据不会进入模型,GDPR 和 HIPAA 的合规性也得到保障;状态持久化机制允许长任务跨会话进行,3 小时的任务可分为 3 次完成;技能生态 SKILL.MD 文档化,能力可重复使用,团队效率提升 3 - 5 倍等等……

Tokens成本降低到这个程度,其他AI公司该如何应对?会不会炸出更多竞争呢?