共计 8120 个字符,预计需要花费 21 分钟才能阅读完成。

最初的 Cursor 功能如同胶水,而现在的 Cursor2.0 则已经具备了独立的编程模型。

然而,这样的转变依然难以解决燃眉之急,因为在编程 AI 的领域,最具实力的竞争者无疑是 GPT 与 Claude。

尽管 TRAE 的表现不及 Cursor,但在 Claude 与 GPT 的双重支持下,仍然能占据一席之地。

这一切发生在 Claude Code 与 GPT5-Codex 尚未问世的时期。

如今,随着 Claude Code 和 GPT5-Codex 的推出,AI 编程的市场格局正在发生巨变,原生大模型正在取代那些依赖外壳和胶水的编程工具。

由于资金问题,GPT 暂时不会停止供货,只要它能够持续占据市场主导地位并获得更高收益,未来 GPT 和 Gemini 同样可能会断供。

这并非 Claude 独自一人努力,GPT 同样希望能够在市场上独占鳌头。

再加上 Claude 不再受到地域限制,更多的是因为其自身的实力,不再需要依靠其他编程产品来进行推广。

完全依靠自身的能力即可。

AI 编程面临的最大挑战在于高昂的 Token 成本。

所有的 AI 编程都无法逃避这个沉重的成本负担。

从 Claude 的角度来看,11 月时 Claude 已经取得了突破,Claude Code 的处理能力已从 150K Tokens 降至仅需 2K Tokens。

这意味着成本直接降低了 98%!

前几天我看到 Anthropic 发布的新技术指南,老实说,第一次阅读后我无言以对。

从 150,000 个 Tokens 直接降至 2,000,这简直是降维打击!

这一变化甚至比 Deepseek 的 3.2 大幅降价还要震撼……

既然自己能够做到,何必为他人铺路呢?

毫不夸张地说,这可能是 2025 年我所见过的最出色的 AI Agent 优化方案。

老实说,以前我参与的一些多工具 Agent 项目,API 账单让我心惊胆战——一个月的费用高达 360,000 美元,谁能承受得了?

如今,Anthropic 将费用直接压至 4,800 美元,节省了 98.7% 的成本。

而且,响应时间也从 20 秒缩短到 5.5 秒。

传统方法将 AI 模型视为数据的中转站,所有中间数据都必须经过上下文处理,这简直是自寻死路!

Anthropic 这次直接将数据处理放在执行环境中,模型只需要负责生成代码和获取结果,决策层与执行层彻底分离。

经过总结,我认为有三个最突出的特点:

- 环境内处理 – 中间数据完全不进入模型,Token 消耗直接减少 99%+

- MCP 代码 API 化 – Agent 转变为程序员,根据需求自行导入工具

- 真实数据验证 – 不再是纸上谈兵,生产环境每月节省 355,200 美元

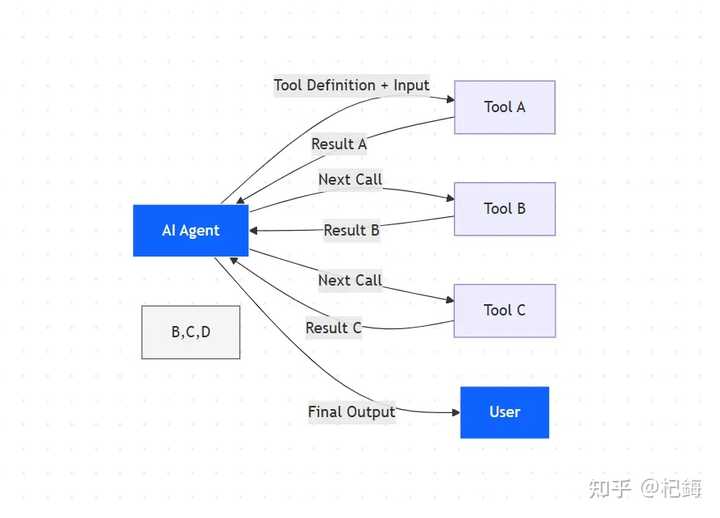

那些参与过多工具 Agent 开发的人都明白,现在面临的问题并非简单的优化所能解决,而是 架构性缺陷。

想要功能全面,就必须连接多个工具;若想节省 Token,功能就必须减少。

这并不是两难的选择,而是一个死循环。

坦白说,企业级 Agent 没有 50 到 200 个工具根本无法运转。

数据库查询、发送邮件、对接 Salesforce、Slack 协作、GitHub 集成,这些都是标准配置。

我之前的项目,仅在工具接入上就耗费了两个月的时间。

更麻烦的是调用频率。

一个复杂的工作流程往往需要 10 到 30 次工具调用,链式依赖 带来的困扰——工具 A 的输出传递给工具 B,B 的输出再传递给 C,每次都要在上下文中进行数据转换。

传统架构无法实现并行处理,只能老老实实地串行执行,眼睁睁看着延迟增加。

调用次数与成本的关系如下:

| 任务复杂度 | 调用次数 | 数据量 | Token 消耗 |

|---|---|---|---|

| 简单任务 | 3- 5 次 | 2K-5K | |

| 中等任务 | 10-15 次 | 10-50KB | 20K-50K |

| 复杂任务 | 20-50 次 | 100-500KB | 100K-500K |

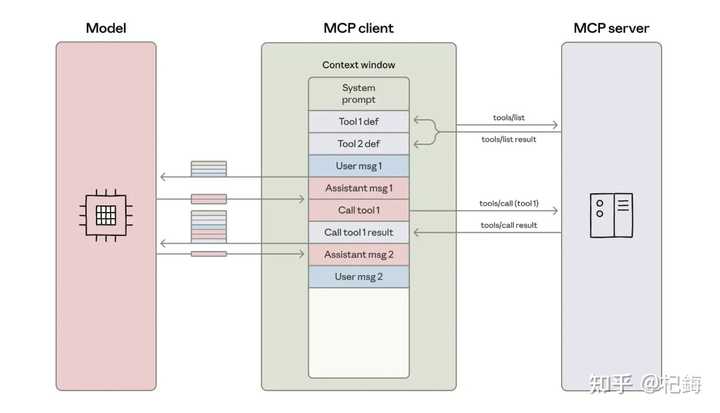

MCP (Model Context Protocol)协议的推出无疑是个好消息,它统一了工具接入的标准。

过去每个服务都需要独立的 SDK、认证和数据格式,现在通过 JSON Schema 定义工具签名,使用 list_tools() API 便可自动发现工具,大大简化了流程。

但是!

尽管 MCP 解决了接口碎片化的问题,理论上可以接入任意数量的工具,但实际上仍然受到上下文窗口的限制。

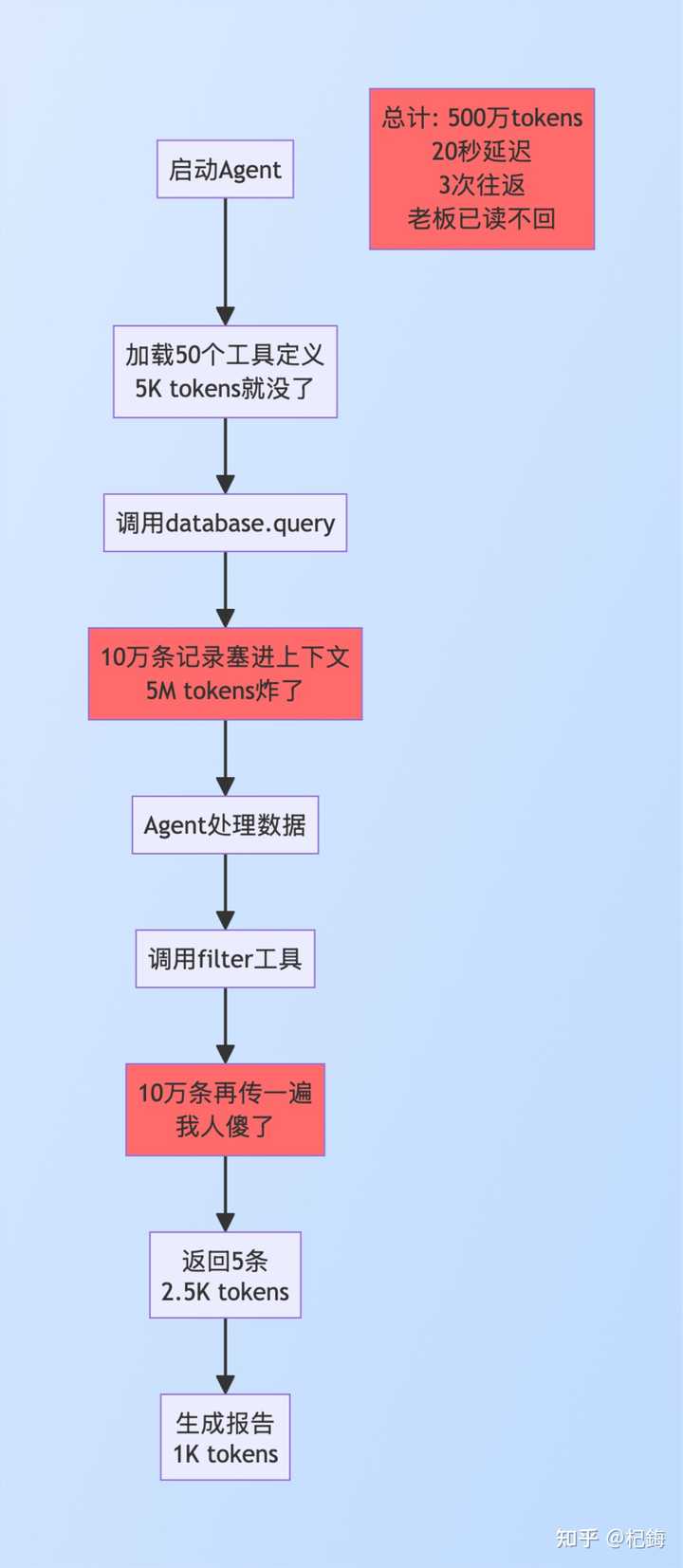

例如在一个项目中需要从 10 万条记录中筛选出 5 条来生成报告。

传统方法的流程如下:

阶段 1 – 工具定义预加载:

- 将 50 个工具定义全部放入上下文

- 还没开始工作,5,000 Tokens 已被消耗

- 我当时就觉得有问题

阶段 2 – 数据检索(这里是重点):

- Agent 调用 database.query()

- 100,000 条记录 → 全部进入上下文

- Token 消耗:100,000 条 × 50 Tokens = 5,000,000 Tokens

- 延迟:序列化、传输、解析,至少需要 15 秒

- 问题是:10 万条中 99,995 条都是无用数据,全部都进了上下文

阶段 3 – 数据过滤:

- 调用 filter()工具

- 10 万条记录再传一次(没错,又传一次)

- 返回 5 条结果

阶段 4 – 生成报告:

- 终于只传递 5 条了

- 但前面的过程已经崩溃了

总账单:

- Token:5,006,000(约 500 万)

- 往返:3 次

- 延迟:20 秒

- 最具讽刺意味的是:10 万条数据走了一遍,真正有用的却只有 5 条

流程如下:

这说明了什么?

传统架构将 AI 模型视为数据传输的中转站,所有数据都必须经过模型的处理。

模型不仅要决策,还要承担数据搬运的角色,Token 消耗与数据量成正比,这样怎么不崩溃?

工具定义的预加载是第一个大问题。Agent 启动时就必须将所有工具定义加载到上下文中:功能描述、参数说明(类型、必填项、默认值、验证规则)、返回格式及 2 至 3 个使用示例。

以 50 个工具为例,基础开销为 50 × 100 Tokens = 5,000 Tokens。然而,规模效应是最令人厌恶的:

200 个工具直接就要 20,000 Tokens 起步。

更有趣的是工具的利用率。

经过统计,单次任务平均使用 3 - 5 个工具,利用率仅为 2.5%。

换句话说,97.5% 的工具定义 Tokens 完全是浪费。

为什么不能按需加载?

因为传统架构要求预先声明所有工具,模型必须“看到”所有选项才能进行选择。

中间结果的传递:数据重复传输所带来的天坑。

Salesforce 的真实案例:

颠覆传统:全新高效的数据处理架构

每次网络往返耗时 500 毫秒,三次总共 1.5 秒光是在等待。

数据序列化还存在隐性成本。

原始 1KB 数据转为 JSON 后会膨胀到 1.5-2KB,膨胀系数为 1.5- 2 倍。

模型还需时间解析 JSON 结构。

Anthropic 的解决方案归结为一句话:不再优化,而是更换架构。Agent 不再是工具的使用者,而是代码的创造者。MCP 服务器不再充当函数调用接口,而是代码模块。

核心理念听似简单,实施起来却极具挑战:模型不再执行工具,而是生成执行工具的代码。

代码在独立环境中运行,所有数据处理均在此环境内完成,模型仅接收最终结果。

MCP 服务器重构为代码 API,实现从函数调用到模块导入(这一转变至关重要)。

// 传统方式(每次调用都是灾难)agent.call_tool("search", {query: "..."})

// 代码执行方式(简洁明了)import {search} from 'mcp-server'技术实现(支持 TypeScript 和 Python)!

TypeScript 实现:

// mcp-servers/salesforce/index.ts

export class SalesforceClient {async search(params: SearchParams): Promise {

// 实现全部在执行环境中,模型完全不知情

const results = await this.api.query(params);

return results;

}

async update(id: string, data: object): Promise {

// 所有操作都在环境内部,速度极快

return await this.api.update(id, data);

}

}Python 实现:

# mcp_servers/salesforce/__init__.py

from typing import List, Dict

class SalesforceClient:

def search(self, query: str) -> List[Dict]:

"""在环境内执行,不经过模型上下文"""

results = self._api_call(query)

return results

def filter_high_value(self, records: List[Dict], threshold: float) -> List[Dict]:

"""使用原生 Python 进行过滤,快速高效"""

return [r for r in records if r['revenue'] > threshold]类型提示真是个好工具:IDE 自动补全、类型检查、文档悬停,开发体验提升飞速。async/await 原生支持,并发性能显著提高。

按需加载的懒加载机制(这个设计让 Token 消耗降到最低)!

传统方式:预加载 50 个工具 = 5K tokens

代码执行:只导入 2 个工具 = 0 tokens

为什么是 0?

因为导入语句并不占用模型上下文!

动态导入实现:

// 运行时根据需求导入,想用哪个直接导入

const toolName = determineRequiredTool(task);

const module = await import(`mcp-servers/${toolName}`);

const tool = new module.Client();search_tools 工具发现 API(这个设计非常聪明)

async function search_tools(query: string): Promise {

// 轻量级元数据,每个工具

tool.tags.includes(query) ||

tool.description.includes(query)

);

// 按相关性和流行度排序

return matches.sort(byRelevance).map(t => ({

name: t.name,

summary: t.summary

}));

}元数据索引在启动时构建一次,后续查询响应时间为 10 毫秒。倒排索引加内存缓存,性能达到极致。

实际使用场景:

- Agent 需要“发送邮件”

- 调用

search_tools("email")→ 返回 3 个邮件工具(150 tokens) - Agent 选择“Gmail Sender”

import {GmailSender} from 'mcp-servers/gmail'- 仅加载此一个工具,其余 197 个工具完全不受影响

工具选择逻辑:描述匹配度 + 历史使用频率 + 上下文相关性。

Agent 已经变成了程序员,模型的角色从“执行者”转变为“编排者”。它生成代码,但并不直接执行工具调用。这需要保证代码质量:

- 使用 ESLint、Pylint 进行自动语法检查

- 通过 TypeScript/Python 类型系统进行类型校验

- 复用最佳实践的代码模板库

模板库减少了生成错误。例如数据库查询标准模板、API 调用重试模板,都是经过验证的。

始终在环境内处理:数据不出环境。

执行环境的安全隔离!

安全第一,架构为:沙箱 + 资源限制 + 实时监控。

沙箱技术(结合 Docker 与 seccomp 多层防护)

- 网络隔离:仅能访问 MCP 服务器,所有其他外部连接被禁止

- 文件系统隔离 :代码库为只读,只有

/tmp目录可写,防止破坏 - 进程隔离:独立容器,进程间完全隔离

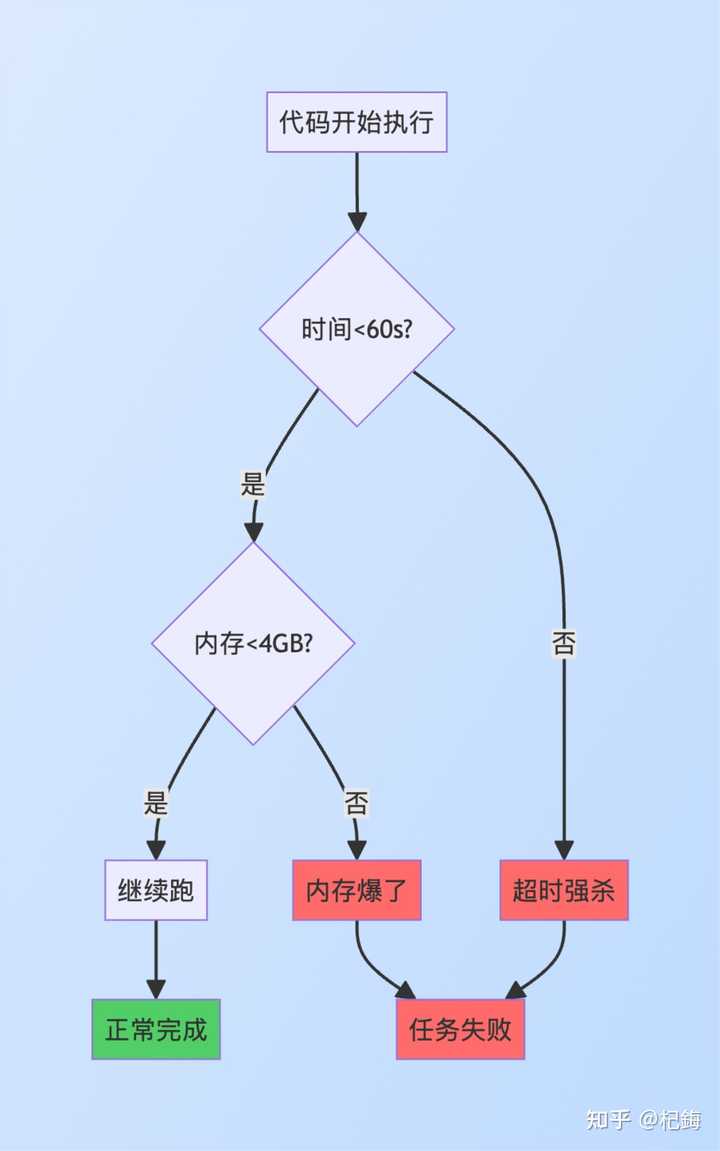

资源配额(固定规则)

- CPU:2 核

- 内存:4GB

- 执行

超时后使用 SIGALRM 信号强制终止。内存溢出有 cgroup 限制,OOM killer 保护宿主机。

核心技术为数据流重定向!

Salesforce 案例改写版(对比极为明显)

智能数据处理:提升效率与节省成本的全新方法

数据流向示意图:

数据库 → 执行环境内存(1000 条,模型无法见到)↓ 过滤操作

执行环境内存(50 条,模型无法见到)↓ 进行聚合计算

执行环境内存(汇总对象)↓ 返回

模型上下文(仅汇总,约 100 个 tokens)执行耗时:

- 数据库查询:2 秒

- 环境内过滤:0.05 秒

- 环境内聚合:0.05 秒

- 总计:2.1 秒

Token 节省:1000 条数据未被序列化,50 条数据未被传输,只有汇总返回。51K → 100 = 99.8% 的节省。

内存管理方面,环境内存中处理了 100K 条记录,模型对此毫无察觉。选择合适的数据结构至关重要:JavaScript 数组和 Python 列表,原生性能最佳。

处理超大数据集时采用 Generator 逐条进行,避免全量加载:

function* 处理大数据集(data) {for (let item of data) {yield 转换项(item); // 逐条处理,节省内存

}

}实时内存监控:

const 内存使用 = process.memoryUsage();

if (内存使用.heapUsed > threshold) {// 内存接近极限,切换到流式处理}将 50 次调用合并为 1 次(这一优化实在出众)

// 传统方式:50 次工具调用 = 50 次往返 = 25 秒的等待

// 代码执行:通过一个循环完成

const 结果 = [];

for (let i = 0; i 进阶并发版本:

// 50 个并发请求,仅需 0.5 秒

const 结果 = await Promise.all(items.map(item => 处理项(item))

);并发控制以防服务器超载:

import pLimit from 'p-limit';

const 限制 = pLimit(10); // 最多 10 个并发

const 结果 = await Promise.all(items.map(item => 限制(() => 处理项(item)))

);错误重试机制增强容错性:

async function 重试(fn, 次数 = 3) {for (let i = 0; i 效果对比:真实数据的经济效益:

Token 节省率计算:

延迟优化:

Claude 的这一手法,展现了诸多优势!

自己完全能够掌握,不再需要依赖他人的帮助……

1. Token 效率:成本显著降低

不同规模的真实成本对比,这张表格让多少老板流泪!

实施成本如下:

- 环境搭建:$50K(一次性费用)

- 每月维护:$5K

中型规模回本0.14 月 ≈ 3.6 天

3 年总拥有成本对比(传统与代码执行):

传统:$360K × 36 = $12.96M

代码执行:$50K + ($4.8K + $5K) × 36 = $402.8K

3 年节省:$12.96M – $403K = $12.56M(节省 96.9%)

2. 渐进式工具发现:再也无需预加载

search_tools 的完整实现,这个 API 设计实在精妙!

数据处理的全新革命:如何高效管理与查询工具

在现代软件开发中,构建高效的数据索引结构显得尤为重要。下面我们将探讨一个名为 ToolMetadata 的接口,它为工具的相关信息提供了一个全面的框架。通过该接口,我们能够清晰地定义工具的名称、分类、标签、描述及摘要等内容。

首先,我们通过加载轻量级索引来获取所有的工具数据,假设我们只需加载这 200 个工具一次,这将消耗约 10K tokens 的资源。接着,我们会进行关键词匹配,筛选出那些其标签或描述中包含查询内容的工具。

在获取到匹配结果后,我们将通过 TF-IDF 算法计算每个工具的相关性得分。我们将根据相关性和流行度的加权评分进行排序,从而确保返回的结果既相关又符合用户需求。最终,我们会选出得分最高的前十个工具进行展示。

在相关性计算过程中,我们将查询字符串分解为多个单词,并逐一与工具的名称、摘要及标签进行匹配。通过这种方式,我们能够有效评估出工具的相关程度。

启动时,我们还会构建一个倒排索引,确保查询响应时间在 10 毫秒以内。此索引将工具名称映射到其相关的词汇上,从而实现 O(1)的查询复杂度,显著提高搜索效率。

通过这种方式,我们对比了传统方法和新兴的 search_tools 工具在 Token 使用上的差异。传统方法需要加载 200 个工具,消耗 20K tokens,而新的方法仅需 150 tokens 来返回三个匹配结果,实现了 99.25% 的节省。

3. 处理海量数据:让数据量不再是问题

我们可以看到,随着数据量的增加,性能曲线的优势愈发明显。性能的拐点出现在 100 行数据时,使用传统方式处理少于 50 行的数据更为简便,而超过 100 行时则表现出明显的优势。

在动态策略选择方面,我们会估计数据源的大小,并根据预估结果选择最佳处理方式。这种灵活的适应性让我们能够高效处理不同规模的数据。

在数据管道的构建中,我们采用链式操作来确保内存使用峰值保持在较低水平。我们的处理流程包括数据清洗、格式转换、分组聚合和指标计算等步骤。

此外,通过流式处理技术,我们能够逐批处理超大数据集,确保内存使用可控。例如,在处理 100K 行数据时,内存峰值仅需 500MB,而不是全量加载时的 5GB。

最后,我们还重点关注编程控制流的简化,包括循环、条件和错误处理等,优化了调用次数,显著降低了延迟。同时,我们确保敏感数据不进入模型,符合 GDPR 和 HIPAA 等隐私保护标准。通过状态持久化机制,我们能够在长任务中实现检查点,分阶段完成任务,大大提升了工作效率。