共计 1679 个字符,预计需要花费 5 分钟才能阅读完成。

一些用户反馈称,GPT-5 的编程能力已经达到,甚至在某些特定任务上超越了 Claude-4。

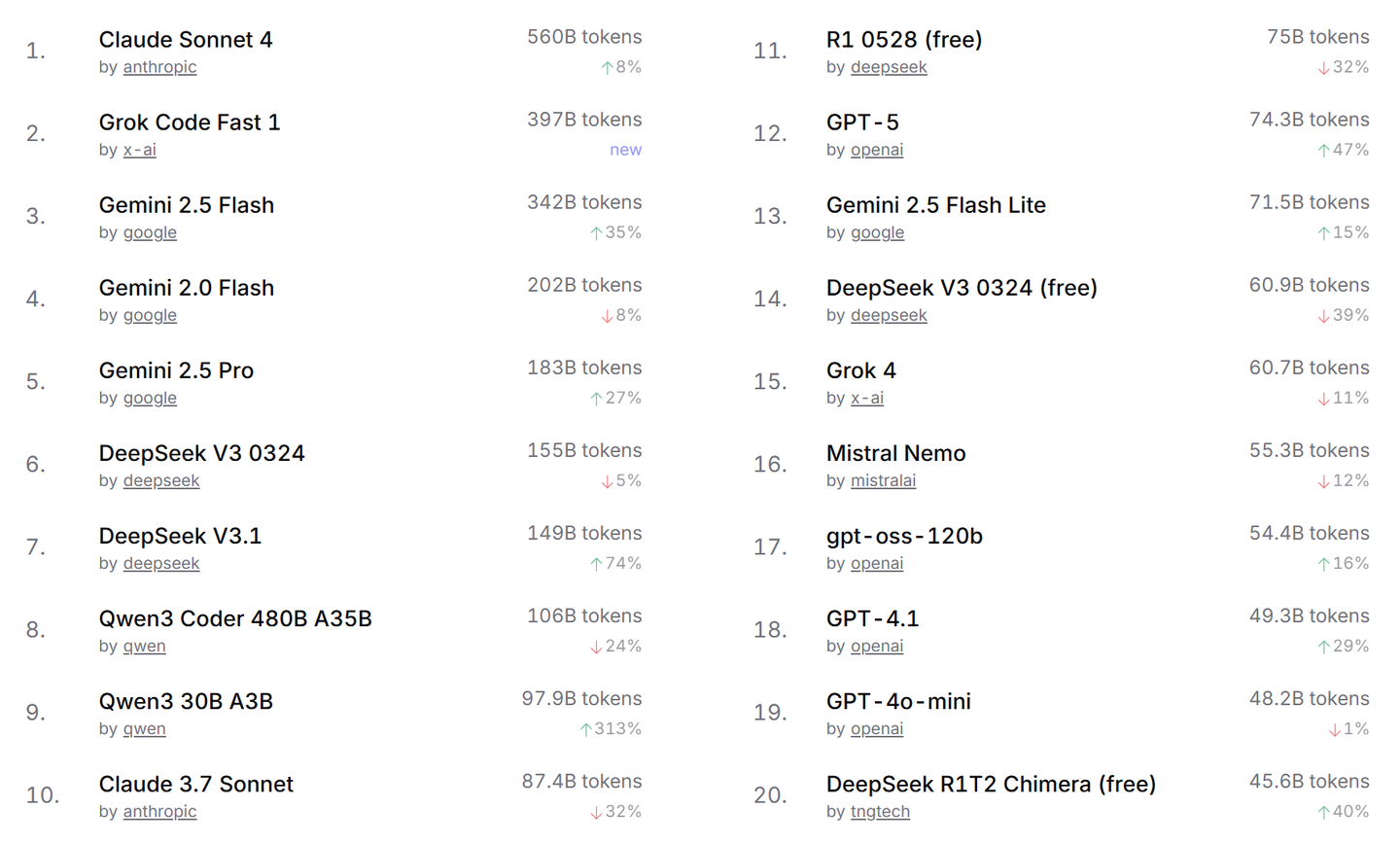

然而,令人费解的是,Claude-4 在 OpenRouter 的定价显著高于 GPT-5,但实际使用量却显然更为庞大。实际上,本周 GPT-5 的使用量甚至低于 Claude 3.7,与 Grok 4 之间的差距也不大。这究竟是为何呢?

是因为用户的习惯所致,还是说其能力确实不够呢?

我认为并非如此。

可以说,GPT-5 是完全符合 OpenAI 设定的目标。

那些偏爱使用 o3 这种推理小模型并结合合成数据的用户,基本上能够毫无障碍地转换到 GPT-5 和 GPT-5 Pro,这些模型更专注于判断对错。由于强化学习的训练必须围绕“对与错”的可验证命题进行,因此为了让强化学习有效运作,需要设定一个停止点,否则它会陷入无尽的循环。这个停止点就是可验证的“对与错”,例如代码能够成功运行或者证明是有效的。

而喜欢 GPT-4、GPT-4.5、o1 Pro 和 4o 这类中大型模型的用户,恐怕难以适应,因为这些模型的表达流畅且细腻,具备人类的洞察力。例如:我需要准备下周的演讲稿,希望它更口语化,让我看起来像行业内的专家,气定神闲、轻松幽默,并要求设计合适的语速和语调。在这种情况下,使用 GPT-5 这样的合成数据小模型并不适合,而应选择经验丰富的 GPT-4.5、Gemini 2.5 Pro,或者 Sonnet 3.5 的前两版(那时合成数据还未如此强大,RLHF 也运作得相对顺畅)。

从本质上讲,这两种数据及两种强化学习方式之间存在竞争与拉锯。

数据的对抗:

自然数据包含了更丰富的人类表达形式,表现生动活泼,但错误频出,对长链推理造成负面影响。

合成数据则提供更为结构化和准确的表达,错误较少,推理更为稳定,但往往显得缺乏生气。

强化学习的对抗:

一种是基于人类反馈的强化学习(RLHF),其验证条件依赖于人类的偏好,具有一定的精英主义色彩。另一种是纯理性主义推理(RL Reasoning),其验证条件不受人类影响,而是取决于自然规律。如果人类参与其中,主要是为了梳理数学与逻辑的公理体系,并设定代码能正确运行的语法和结构。

在此,有一个颇为尴尬的事实,科学既不是人类的偏见,也不是领导的决策所能左右,更非纯理性主义的产物。科学无法自我证明,它是一种经验主义,需要依赖事实,而最终验证科学的唯一途径只有实验。如果广义相对论在数学上再完美,没有实验支持,也只是一种假说。对科学相关内容而言,精确的数据往往比推理更为重要。

假设 Anthropic 和 OpenAI 在生物医学领域的数据相同,A 社采用弱推理,O 家则使用强推理,最终的结果可能会相近。

GPT-5 引入了大量优质的生物医学数据,如果你想要推理科学知识,那就像在算命一样。科学在现代生活中扮演着至关重要的角色,因此我们对优质数据的需求在当前环境下是无法消退的。

因此,我们需要明确当前任务的性质。

若是涉及数学、逻辑,以及一些与数学逻辑高相关性的代码,使用 GPT-5 这样的模型将是明智之选,这是 OpenAI 的强项。

如果任务与审美、好坏、感受等相关,那么你应选择 GPT-4.5、Claude Sonnet 3.5(我推荐 3.6,4.0/4.1 则相对不够灵活)或 Gemini 2.5 Pro。在审美方面,我特别欣赏 Anthropic,无论是网页设计还是语言风格,都展现出一流的水平。(尽管,他们的产品和公司理念中弥漫着刺鼻的精英主义气息。)

如果是关于科学的内容,那就要看哪家公司恰好拥有你所需的数据。并不一定 OpenAI 就是最好的选择,可能 Grok 和 Gemini 也能提供优质服务。Google 在大数据处理方面有其独特优势,很多知识型基准测试未必能够测量出其真正潜力。